4月17日,RedPajama宣布开源1.2万亿token数据集,协助开发者练习类ChatGPT大言语模型。这也是现在类ChatGPT领域,全球最大的开源练习数据集。(地址:huggingface.co/datasets/to…

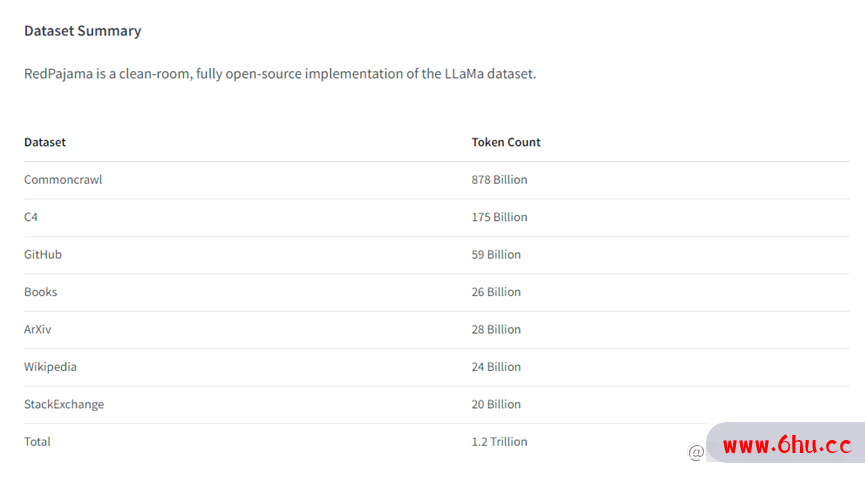

据悉,RedPajama完美仿制了LLaMA模型上的1.2万亿练习数据集,由维基百科、GitHub、一般抓取、C4、图书、ArXiv(知名论文网站)、Stack Exchange七部分组成。完好数据集容量约5T,依据数据运用法令现已答应商业化。

ChatGPT插件合集:

引荐一款国人开发的ChatGPT浏览器插件

更新了!超高人气的IDEA插件更新4.0 看看都有啥?

这款国人开发的chatgpt+idea插件又迎来更新~

开箱即用的「ChatGPT」插件,还不赶紧来试试? – 掘金 ()

最近的类ChatGPT开源项目实在是太卷了,不仅开源了根底模型,就连核心练习数据集也陆续开源,生怕开发者缺衣少粮服务真是周到位啊。但一次性开源如此巨大的数据集还真是少见。

ChatGPT的呈现加快了生成式AI的商业化落地,并引领了全球新一轮AI技术变革。因为Open AI没有开源ChatGPT,LLaMA、Alpaca、Guanaco、LuoTuo、Vicuna、Koala等一大批优异的开源项目如漫山遍野般快速增长。

其间,由Meta AI发布的LLaMA是公认最佳的ChatGPT平替产品,其间,70亿参数模型经过1.2万亿数据练习单个CPU就能跑,比较适合中小型企业和一般开发者。但LLaMA只能用于学术研究不答应商业化。所以,RedPajama仿制了LLaMA1.2万亿练习数据,协助开发者加速大言语模型练习进程。

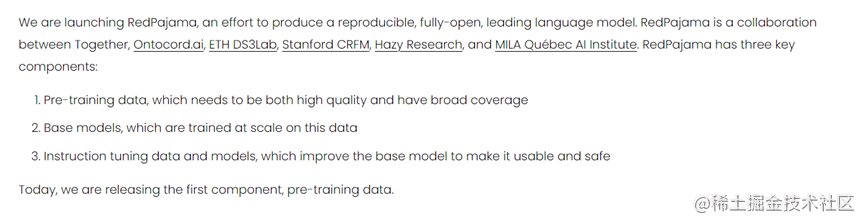

其实RedPajama自身就是一个类ChatGPT大言语模型由Together、 Ontocord.ai、ETH DS3Lab、Stanford CRFM和Hazy Research一同合作开发。估计5月份,RedPajama会将大言语模型进行开源。

本次开源的数据集,RedPajama受LLaMA 70亿参数模型启发,依照其论文的数据模式从维基百科、GitHub、一般抓取、C4、图书、ArXiv、Stack Exchange抓取了1.2万亿练习数据,并进行了数据优化、过滤。

其间,一般抓取渠道获取了8780亿数据,并经过多个质量过滤器进行过滤,包括挑选类似维基百科页面的线性分类器。C4获取1750亿,依据规范 C4 数据集。GitHub获取590亿,按许可证和质量过滤;图书获取260亿,包括敞开书籍的语料库,并依据内容相似性进行去重。

ArXiv获取280亿,去除了样板文件的科学文章。维基百科获取240亿,依据子集数据删除了样板内容。StackExchange获取200亿,依据子集数据删除了样板内容。总体来说,RedPajama完美仿制了LLaMA的练习数据集。

RedPajama还开源了一切数据预处理和质量过滤器,使得任何人都可以依照数据预备方法仿制 RedPajama-Data-1T。(地址:github.com/togethercom…

RedPajama表示,正在活跃练习类ChatGPT大言语模型,并进行深度优化。依据Alpaca模型的展示,仅需5万条高质量、多样化的指令,就能显着改进对话功能。

现在,RedPajama现已收集了10万条高质量指令,将用于发布RedPyjama模型的指令优化版本。