在过去的一周,世界见证了两家科技巨子最具突破性的人工智能前进。OpenAI 推出了令人惊叹的 AI 视频生成器 Sora,而 Google 推出了 Gemini 1.5 模型,能够支撑多达 100 万个 Token 上下文。

Gemma,是一个轻量级、最先进的开源模型系列,它建立在用于创建 Gemini 模型的研讨和技能的根底上。

什么是Gemma

Gemma 是以拉丁语 gemma 命名,意思是宝石 ,Gemma 从其前身 Gemini 中汲取创意,反映了它在科技界的价值和稀有性。

它们是文本到文本、仅限解码器的大型言语模型,供给英语版别,具有敞开权重、预练习变体和指令调整变体。

Gemma 现已开端在全球范围内供给两种巨细 2B 和 7B,支撑多种东西和系统,并能够在开发人员笔记本电脑和工作站上运转。

2 种模型巨细和功用

Gemma 模型有 20 billion 和 70 billion 参数巨细可供挑选。 2B 模型旨在移动设备和笔记本电脑上运转,而 7B 模型旨在台式计算机和小型服务器上运转。

调整模型

Gemma 也有两个版别:调整版和预练习版。

- 预练习:没有任何微调的基本模型。该模型未针对 Gemma 中心数据练习集之外的任何特定任务或指令进行练习。

- 指令调整:针对人类言语交互进行了微调,前进了其履行方针任务的才能。

与竞争对手相比?

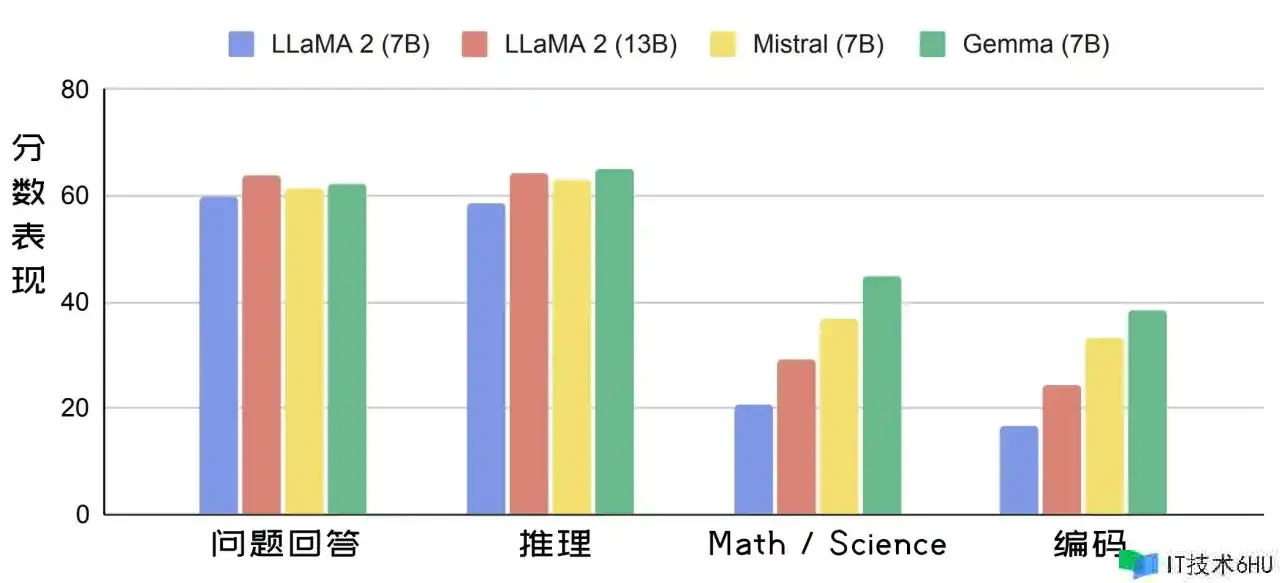

由于 Gemma 体积小,因此能够直接在用户的笔记本电脑上运转。下图显示了 Gemma(7B)的言语理解和生成性能与 LLaMA 2 (7B)、LLaMA 2(13B) 和 Mistral(7B)等类似巨细的敞开模型的比较。

能够在此处查看每个基准的更具体比较。

Gemini 1.5 有什么新功用?

Gemini 1.5 供给了严重增强功用,旨在解决初始版别的缺点:

-

1,000,000个Token上下文:这是目前任何大型根底模型中最大的上下文。 OpenAI 的 GPT-4 具有128K上下文。 - 将有更快的呼应:谷歌正在选用或许为 GPT-4 供给支撑的专家混合 MoE 架构,使得模型能够将提示分解为子任务并将其路由给专门的“专家”,从而明显前进功率和性能。

- 快速信息检索:新模型展示了在很多文本、视频或音频数据中准确定位特定细节的才能明显前进。

- 更拿手编码:大型上下文能够对整个代码库进行深入分析,协助 Gemini 模型把握杂乱的关系、形式和对代码的理解。

能够用来做什么?

以下是 Gemma 的一些或许的运用场景:

内容创造与传达

- 文本生成

- 谈天机器人和对话式人工智能

- 文本摘要

研讨与教育

- 自然言语处理 (NLP)研讨:作为 NLP 研讨的根底,试验技能、开发算法并为该范畴的前进做出贡献。

- 言语学习东西:支撑交互式言语学习体会、协助语法纠正或供给写作练习。

- 常识探究:通过生成摘要或回答有关特定主题的问题,协助研讨人员探究很多文本。

以前需求非常大的模型的任务现在能够运用最先进的、更小的模型。这开启了开发 AI 应用程序的全新方法,很快就能够在智能手机上看到设备内的 AI 谈天机器人——不需求互联网衔接。

尝试开端

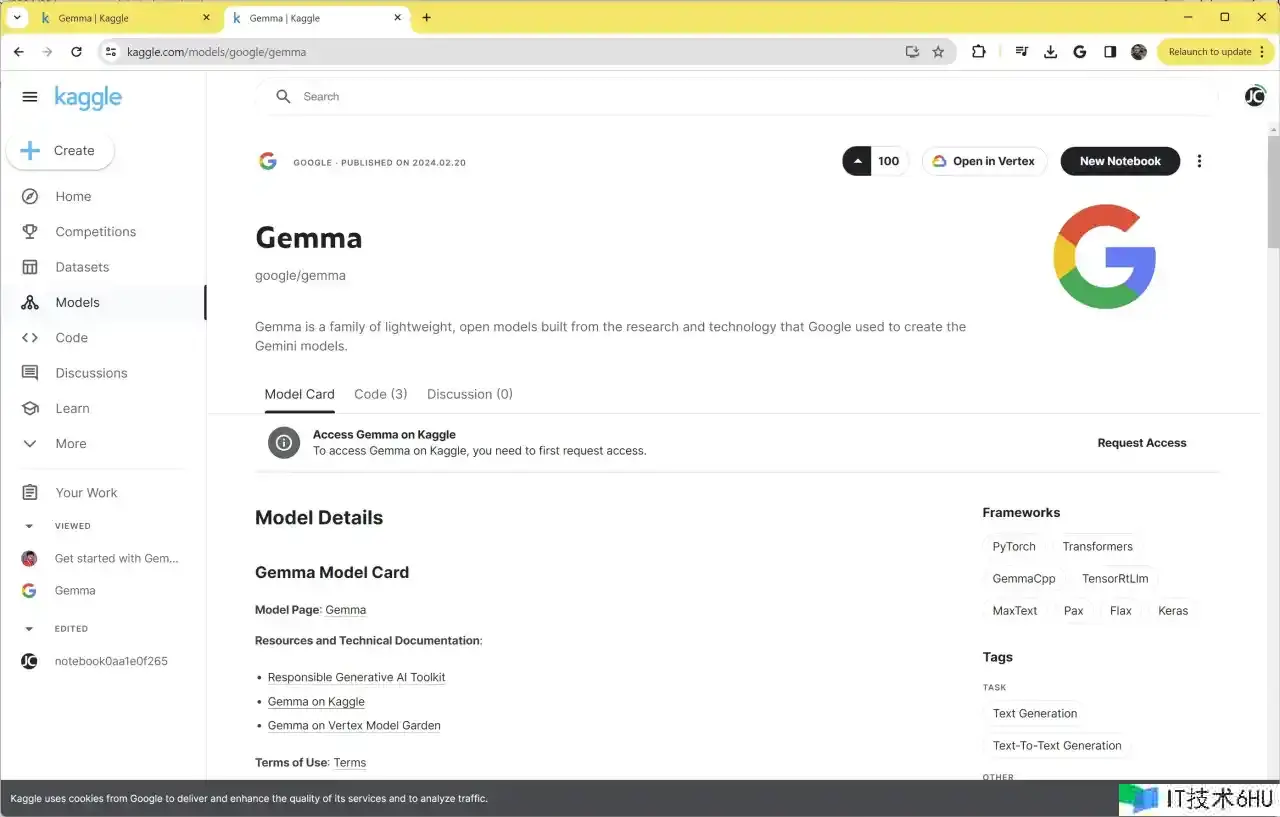

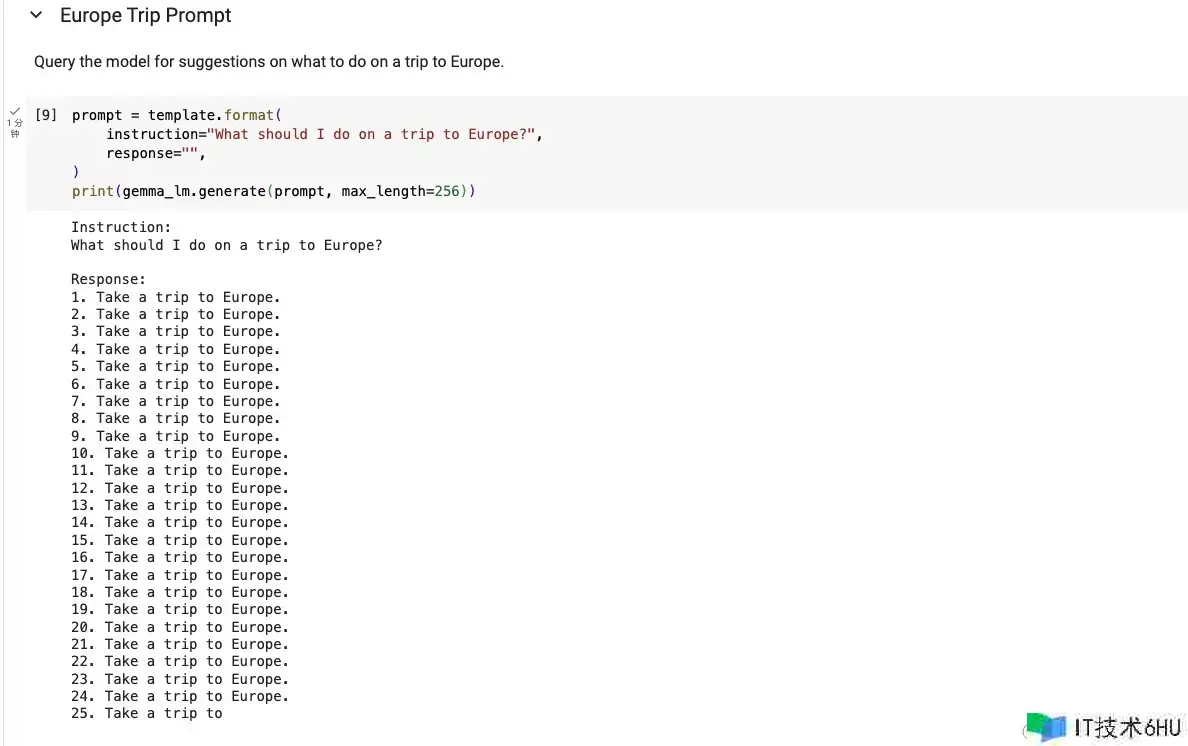

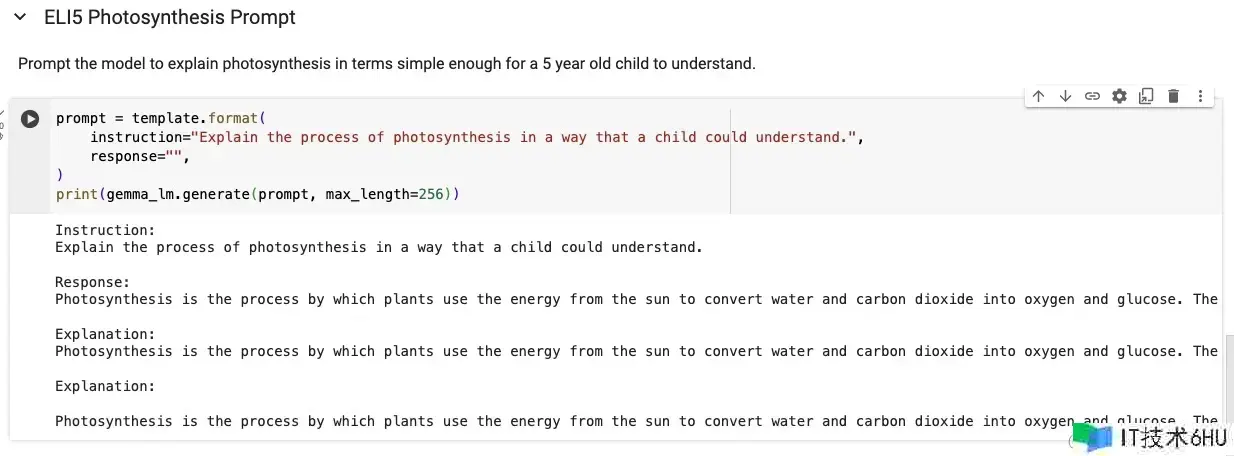

Gemma 模型能够从 Kaggle Models 下载运转。

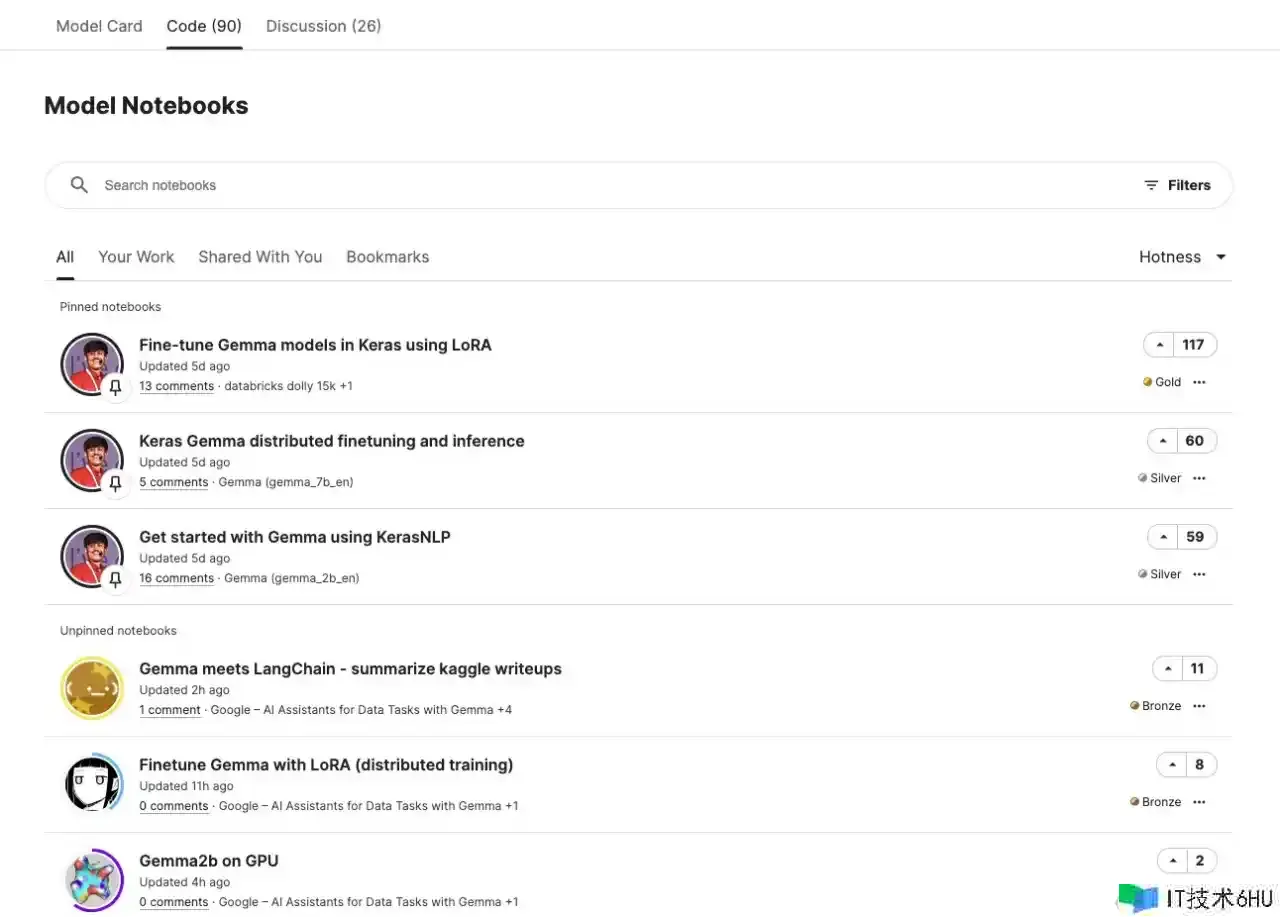

进入页面后,挑选 Code 标签:

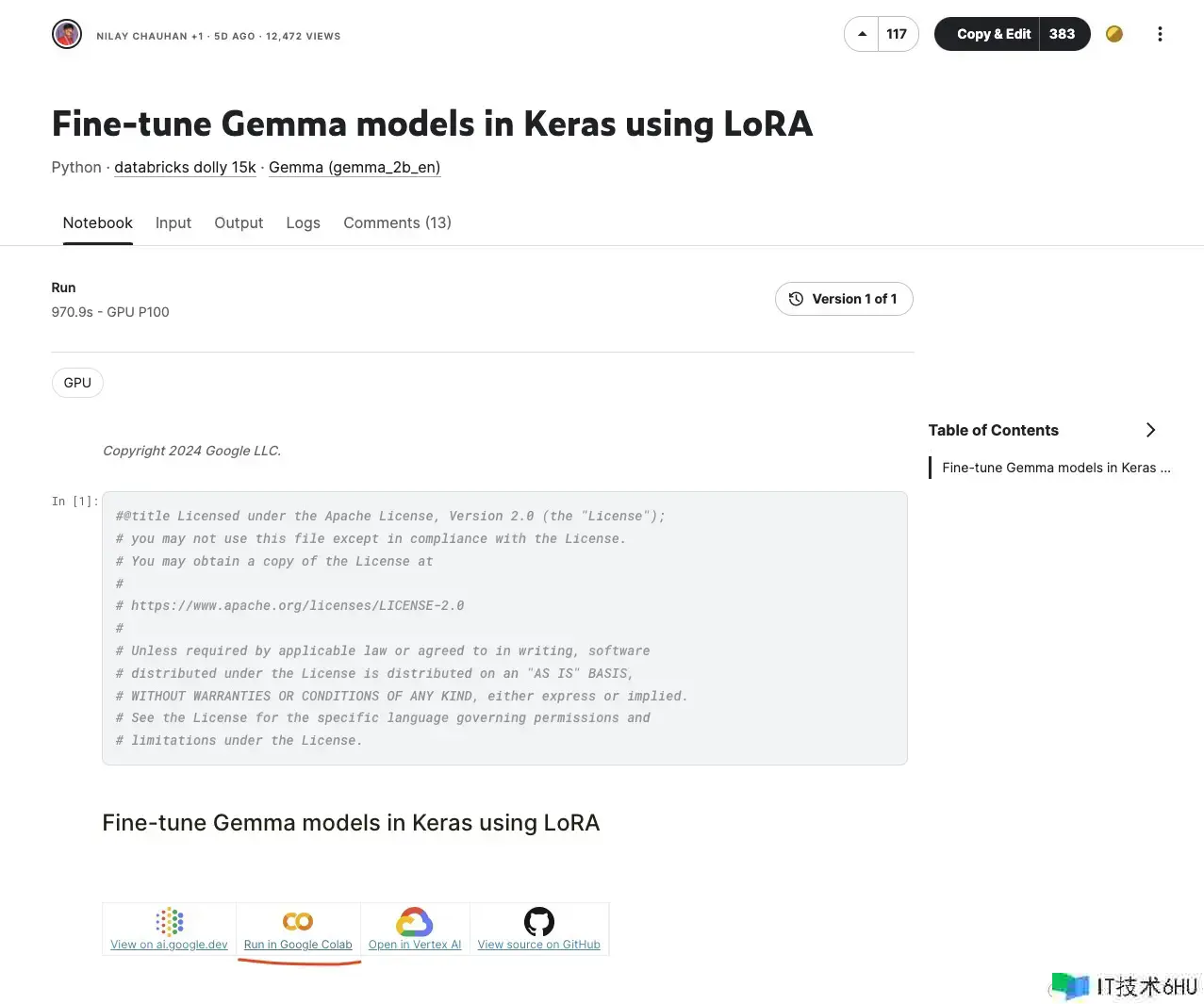

随意挑选一个点击进去,这里挑选第一个:

总结

虽然 Gemma 模型或许很小而且缺乏杂乱性,但它们能够在速度和运用本钱方面补偿这一点。

从更大的角度来看,谷歌不是追逐顾客眼前的振奋,而是为企业培育市场。设想一下,当开发人员运用 Gemma 创建立异的新顾客应用程序时,公司会为 Google Cloud 服务付费。