2024 年,大模型领域的一个趋势越来越清晰:重视优化,面向运用。

在上一年的百模大战中,科技巨头、创业力量你追我赶,将大模型技术卷到了一个新的高度。有了强壮的模型之后,更重要的是将这些才能输出到实践中的运用场景,提高用户体会、构建生态。

正因而,大模型厂商们或是开源,或是推出模型 API,都是希望让效果为开发者所用,以此为基础设施构建起繁荣的大模型生态。

国内的大模型独角兽公司零一万物,也在今天正式发布了 Yi 大模型 API 敞开渠道。

零一万物 API 敞开渠道链接:platform.lingyiwanwu.com/

此次 API 敞开渠道供给以下模型:

-

Yi-34B-Chat-0205:支撑通用谈天、问答、对话、写作、翻译等功能。

-

Yi-34B-Chat-200K:200K 上下文,多文档阅览了解、超长常识库构建小能手。

-

Yi-VL-Plus: 多模态模型,支撑文本、视觉多模态输入,中文图表体会逾越 GPT-4V。

实践上,在半个月前,零一万物已经启动了 Yi-34B-Chat-0205 和 Yi-34B-Chat-200K 两个模型的邀测,许多开发者早就上手体会过一波了。

咱们围观了一下,发现了几个亮点:

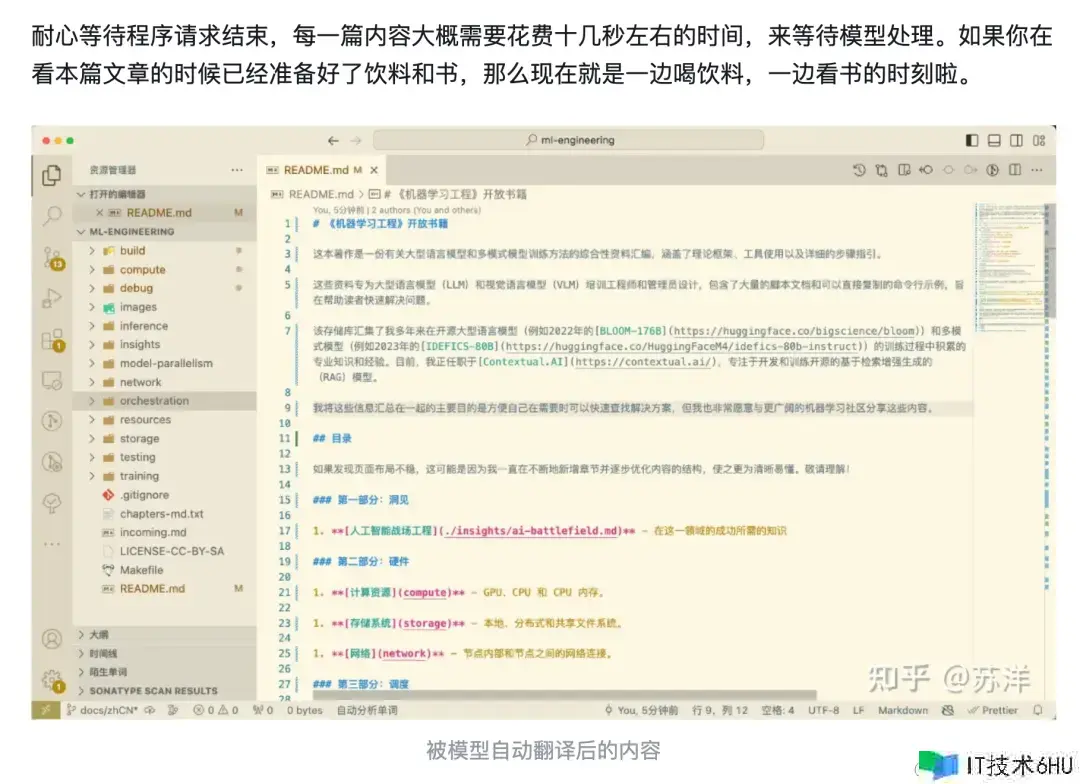

首先,200K 上下文确实强。就拿专业书翻译这件事来说吧,前 HuggingFace 职工、Transformer 核心贡献者 Stas Bekman 写过一本名为《机器学习工程》的电子书。调用 Yi-34B-Chat-200K 之后,知乎闻名技术作者「苏洋」一天之内就完结了长达 264 页的书本翻译作业。

_图源:运用零一万物 200K 模型和 Dify 快速建立模型运用 zhuanlan.zhihu.com/p/686774859

_

其次,在 Yi-34B-Chat-0205、Yi-34B-Chat-200K 之外,零一万物敞开渠道此次同期上新全新的多模态大模型 Yi-VL-Plus。

Yi-VL-Plus 支撑文本、视觉多模态输入,面向实践场景大幅增强。多位用户反馈:「中文体会逾越 GPT-4V。」

GPT-4V 连招牌都没看明白。

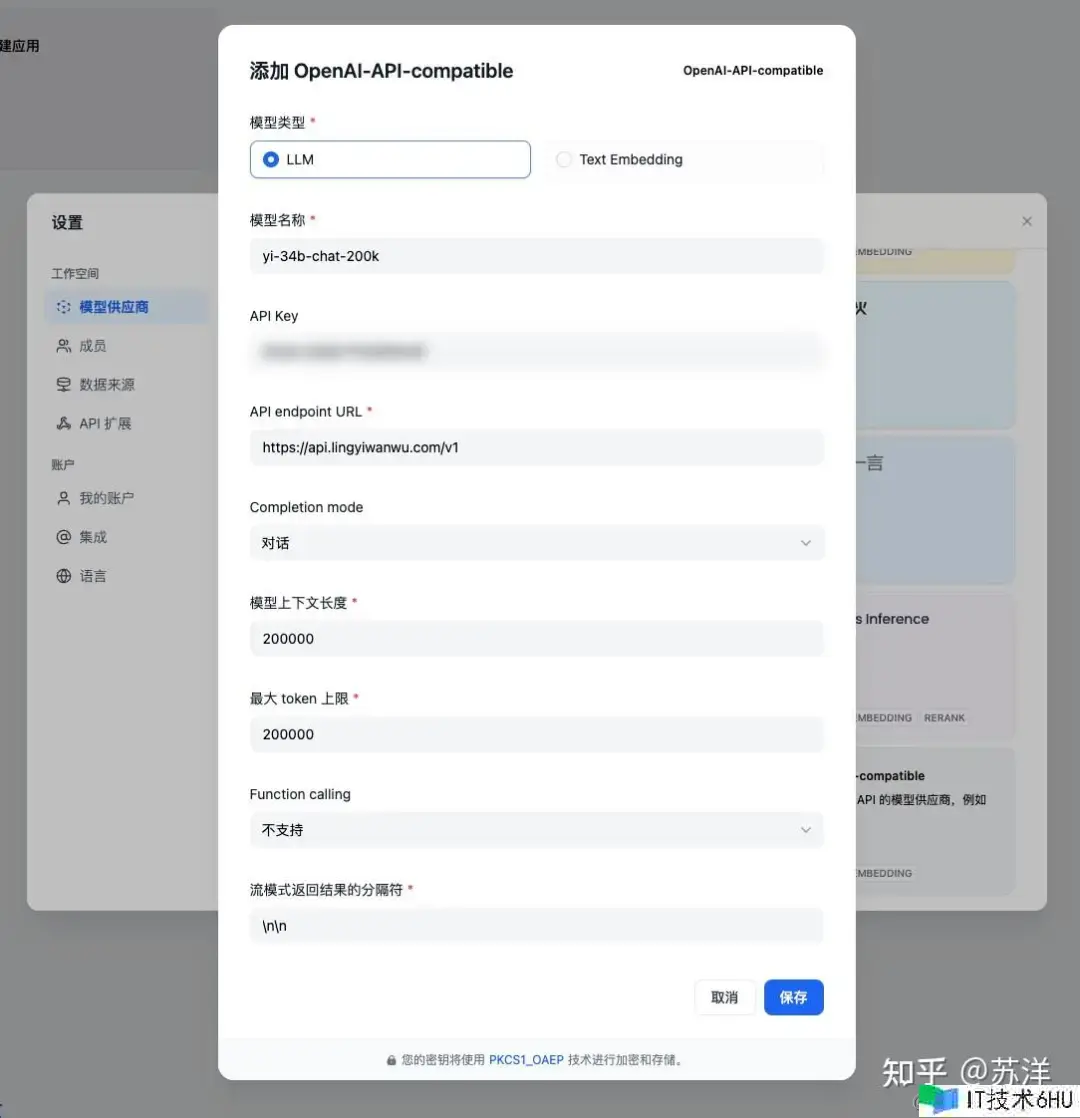

此外,零一万物 Yi 大模型 API 敞开渠道和 OpenAI API 是兼容的,迁移方案时的体会应该也十分丝滑。

当然,Yi 大模型 API 究竟能不能与 GPT-4 Turbo、Gemini 1.5、Claude 3 这些模型的体现一较高下,还需要更多开发者一起考察。

Yi 大模型 API 名额现在限量敞开,零一万物会为新用户免费赠送 60 元,感兴趣的开发者不妨请求体会一下。

200K 上下文的大模型,有多能打?

在此前的内测中,最令人印象深入的不外乎具有超长上下文窗口的 Yi-34B-Chat-200K。

关于大模型的落地运用,上下文窗口是一项十分要害的因素。过去一年里,各家大模型的上下文窗口都在飞速扩展:OpenAI 把 GPT-4 的 32K 直接说到 GPT-4 Turbo 的 128K。谷歌的 Gemini 1.0 仍是 32K,Gemini 1.5 Pro 马上就升级到了 100 万 Token。

前不久,Claude 3 将大模型 API 的上下文长度纪录一下说到了 200K,还宣称有才能敞开 100 万 Token 的上下文输入(虽然现在仅限特定客户)。

要完结更杂乱的实践使命,模型需要能够处理长篇的上下文。更广阔的上下文窗口能显著提高模型的了解深度,在生成内容或答复问题时完成更高的精确性和相关性。这是由于模型能够「回想」并参照较长的文本前史,面对长文章、书本的章节、杂乱对话或其他需长时间累积上下文的情境时,这种才能分外要害。

Yi-34B-Chat-200K 能够处理大约 30 万个中英文字符。咱们能够拿文学类书本来类比,32K 就像是一篇 2 万字的短篇小说(比方《潜伏》原著),128K 大概是一部中篇小说的体量(比方《人世失格》),而 200K 则相当于《呼啸山庄》、《百年孤独》、《骆驼祥子》这类长篇著作了。

以下是 Yi-34B-Chat-200K 对经典文学作品《呼啸山庄》的归纳总结,这部作品中文字数约 30 万字,人物关系错综杂乱,但 Yi-34B-Chat-200K 仍能精准地整理和总结出人物之间的关系。

从行业运用的角度看,Yi-34B-Chat-200K 合适用于多篇文档内容了解、海量数据分析挖掘和跨领域常识融合等,为各行各业运用供给了便利。金融分析师能够用它快速阅览陈述并预测市场趋势、律师能够用它精准解读法律条文、科研人员能够用它高效提取论文要点等,运用场景十分广泛。

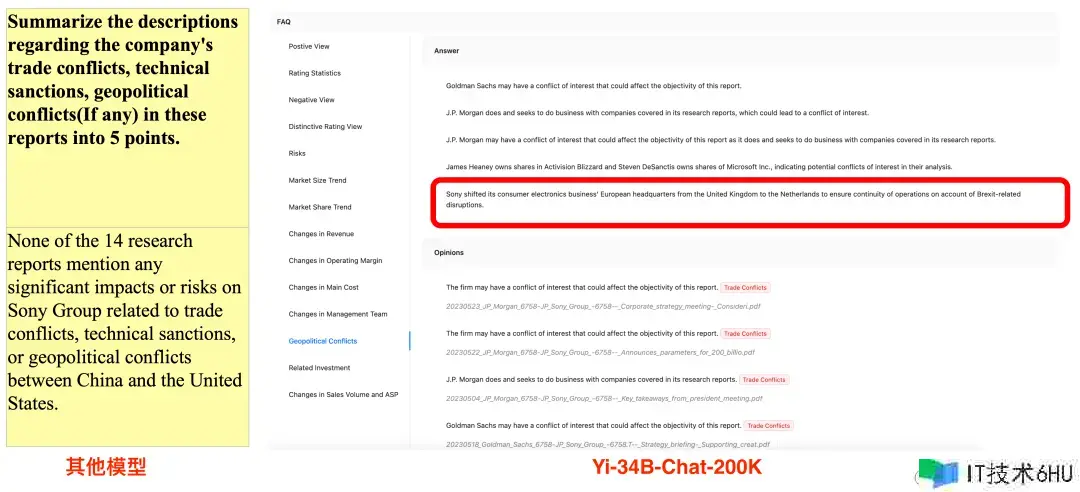

有开发者对比了 Yi-34B-Chat-200K 和某同类模型,从下图咱们能看出,关于「请在 18 万字陈述中找到地缘政治风险」这一 Prompt,Yi-34B-Chat-200K 给出了正确答案「英国脱欧导致索尼总部搬家,导致索尼欧洲事务连续性受影响」,而另外一个模型则表示「无地缘政治风险」,未能完结使命。

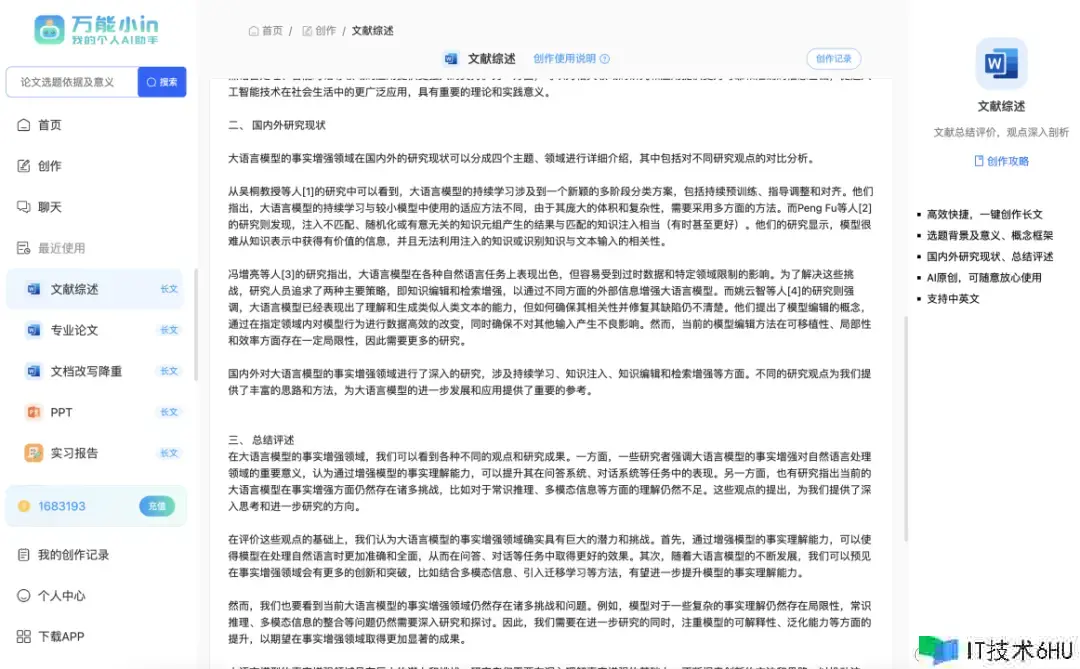

在另一项使命中,开发者要求某个大模型帮忙「撰写文献综述」,成果,交上来的活只干了一半:

切换到 Yi-34B-Chat-200K 之后,方才卡住的使命马上成功履行,篇幅控制、翻译精确度、标注格式都符合要求。

试验数据进一步印证了开发者内测过程中的直观感触:在零一万物针对其进行的「难如登天」测试中,Yi-34B-Chat-200K 的功能提高了 10.5%,从 89.3% 提高到 99.8%。

拼中文体会,这次赢的显然是 Yi-VL-Plus

大语言模型的继续前进往往也会为多模态大模型注入新的开展生机,尤其近几个月以来,多模态领域迎来「井喷」,大家的目光再次聚焦到了多模态大模型的开展上来。

谷歌 Gemini 原生多模态、Anthropic Claude 3 首次支撑多模态才能,随之而来的是,多模态大模型对图画(包含其上文字)、表格、图表、公式的辨认、了解才能已经在全体上了一个新台阶。自然而然,这对其他大模型厂商提出了更高的多模态才能需求。

关于零一万物来说,这既是挑战,也是机会。自成立以来,零一万物在大模型多模态才能上的探究一直在推动,尤其中文场景体现亮眼。

1 月 22 日,零一万物 Yi-VL 多模态语言大模型正式开源,包含 Yi-VL-34B 和 Yi-VL-6B 两个版别,其中 34B 版别在针对中文打造的 CMMMU 数据集上的精确率紧随 GPT-4V 之后,在开源多模态模型中处于抢先位置。

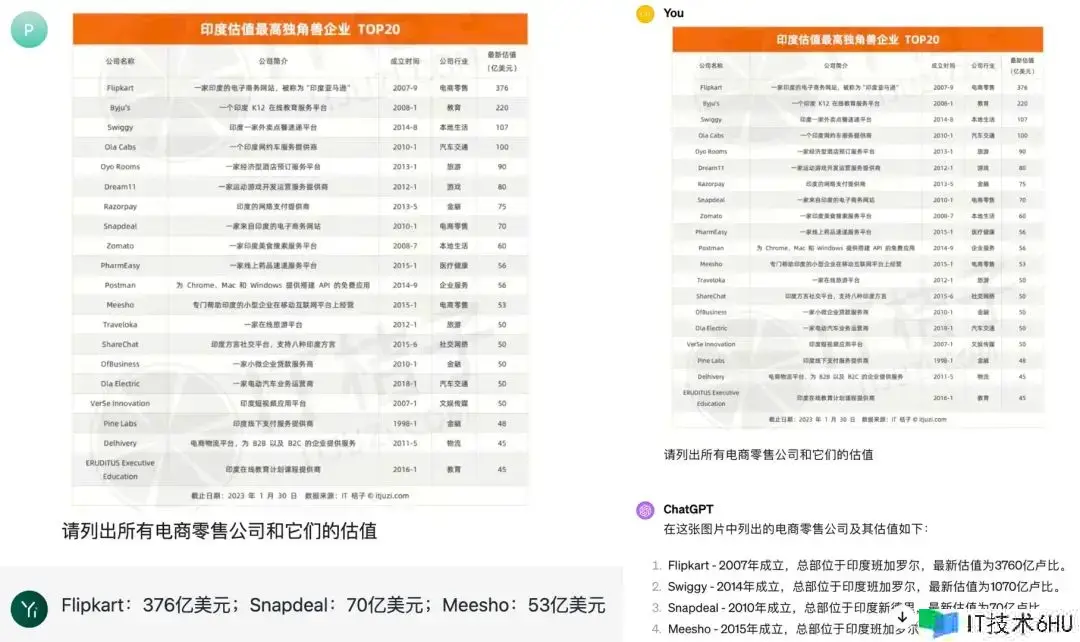

现在,Yi-VL-Plus 多模态模型在原有 Yi-VL 基础上迎来全方位升级,进一步提高了图片分辨率,支撑 1024*1024 分辨率输入,不仅对图片中文字、符号的辨认、了解和归纳才能得到史无前例的加强,在部分中文场景的实践体会更是逾越了 GPT-4V。眼见为实,咱们来详细对比一下开篇说到的这个图文对话示例。

能够看到,Yi-VL-Plus 的答复言简意赅,精确无误,验证了它对图片中文字超强的辨认才能;而 GPT-4V 看似答复了一大堆内容,实则言之无谓,除了「羊肉汤烩面」这个招牌之外,它给出的食物显然是根据一般常识推理出来的,并不是它精确看到的。二者高下立判。

在更精确地搞定一般中文场景的图片辨认之外,此次 Yi-VL-Plus 的一大特点是大幅增强了对实践生产力场景的支撑,既提高了图表(Charts)、表格(Table)、信息图表(Inforgraphics)、屏幕截图(Screenshot)中文字和数字 OCR 的辨认精确性,让模型「看得准」;又支撑了杂乱的图表了解、信息提取、问答以及推理,让模型「答得透」。

咱们相同发现,在这些偏生产力场景的使命中, Yi-VL-Plus 的实践体会仍然要比 GPT-4V 更好。

咱们来看下面这个中文「财务报表数据提取」使命,Yi-VL-Plus 没有被不同部门的数据所利诱,精确无误定位并提取到了销售部门各个季度的数据;而 GPT-4V 显然被杂乱的表格和柱状图数据难倒了,给出的数据中呈现多达三处错误。

在另外一个中文「图表了解场景」中,Yi-VL-Plus(左)在精确性方面相同击败了 GPT-4V(右),后者混杂了电商零售与本地生活服务的概念。

论「火眼金睛」,Yi-VL-Plus仍是更强一点的。

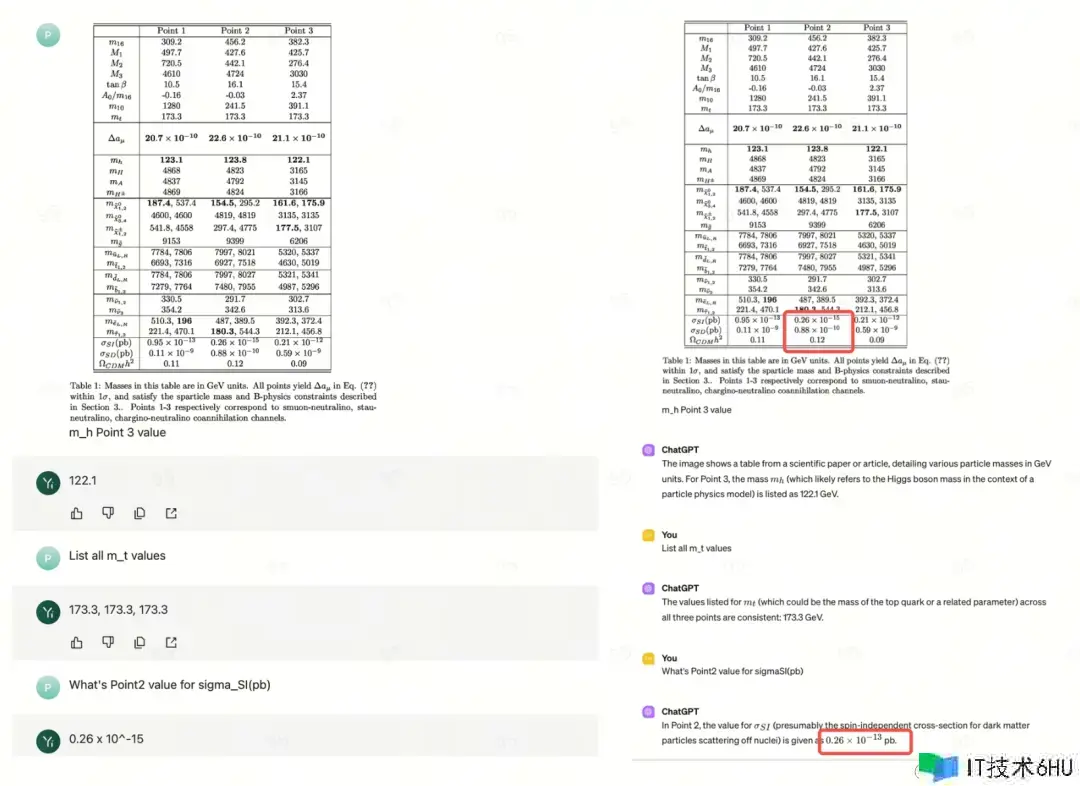

当然,不止中文场景,Yi-VL-Plus 也能轻松处理英文「图表信息提取」使命,在答案精确性方面仍然要强于 GPT-4V。

到了「临门一脚」,GPT-4V仍是出错了。

在充分把握图表信息的基础上,Yi-VL-Plus 还能释放其他多模态才能,比方将图表转化为其他格式,诠释了「技多不压身」。

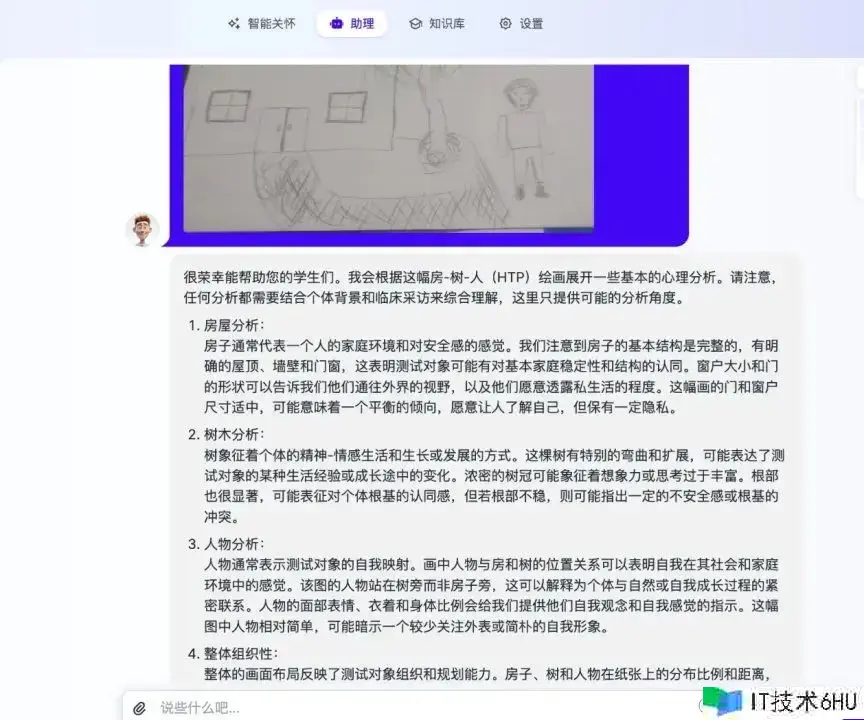

而在下面触及专业常识学习与解读的事例中,Yi-VL-Plus 相同能给出有模有样的专业答复。能够看到,Yi-VL-Plus 能够结合前史病历和图片信息(脱敏数据),较好地完结对青少年心理健康水平解读。

至此,咱们大能够得出这样的定论:中文社区总算迎来了一个功能强壮的多模态大模型。尤其是关于普通用户而言,在生产力场景下足功夫的 Yi-VL-Plus 能够成为他们分析图表、分类常识、汇总数据的绝佳辅助东西,对作业效率的提高显而易见。

写在最终

当今,大模型厂商想要在激烈的竞争中胜出,靠的不再只是炫「冷冰冰」的榜单数据,还要不断下降模型运用门槛,为用户「减负」。自然而然,敞开 API 成为了许多厂商的挑选。

从成立至今,零一万物一方面坚持向大众开源 Yi 系列模型,为开源社区贡献自己的技术力量;另一方面又希望经过敞开 API 让包含开发者在内的更多人用上强壮的对话、多模态大模型,或用来创造或用于作业,这样反过来又将促进这些模型在更多运用场景中的落地,形成双赢局势。

此前,零一万物 CEO 李开复博士曾表示,零一万物将在 Yi 系列大模型的基础上打造更多 To C 超级运用。此次在敞开对话、多模态模型 API 的一起,还强调了开发者东西对促进大模型运用立异的效果,双管齐下,为完成这一目标做好了足够的准备。

零一万物表示,近期将为开发者供给更多更强模型和 AI 开发框架。主要亮点包含:

– 推出一系列的模型 API,覆盖更大的参数量、更强的多模态,更专业的代码/数学推理模型等。

– 打破更长的上下文,目标 100万 tokens;支撑更快的推理速度,显著下降推理本钱。

– 根据超长上下文才能,构建向量数据库、RAG、Agent 架构在内的全新开发者 AI 框架。旨在供给愈加丰厚和灵活的开发东西,以适应多样化的运用场景。

显然,零一万物在自家大模型的开展方向上已经有了老练的思路,未来也势必会走得更远。