马斯克之前揭露控诉OpenAI并宣布要开源自己的大模型,现在马斯克来兑现承诺了,由X.AI推出的大模型Grok来了。

3月17日清晨,马斯克旗下大模型公司 xAI 宣布正式开源 3140 亿参数的混合专家(MoE)模型「Grok-1」,以及该模型的权重和网络架构。马斯克也在X上和OpenAI进行了亲热地互动。

Grok-1的一些详细情况:

- 根底模型基于很多文本数据进行练习,没有针对任何具体任务进行微调;

- 3140 亿参数的 MoE 模型,在给定 token 上的激活权重为 25%;

- 2023 年 10 月,xAI 运用 JAX 库和 Rust 言语组成的自定义练习堆栈从头开端练习。

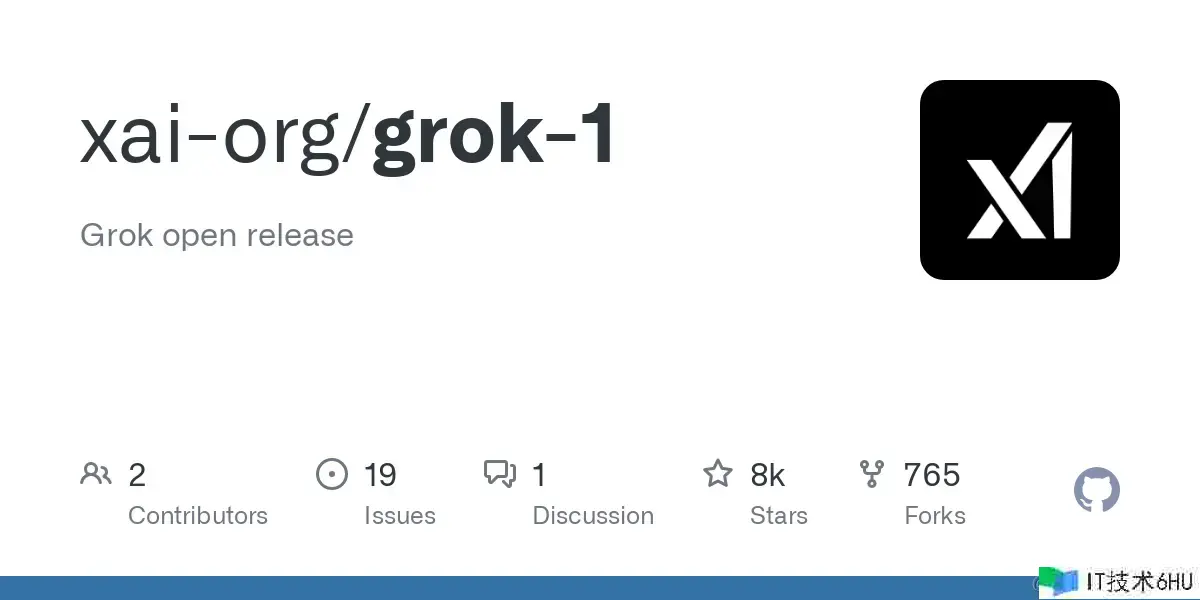

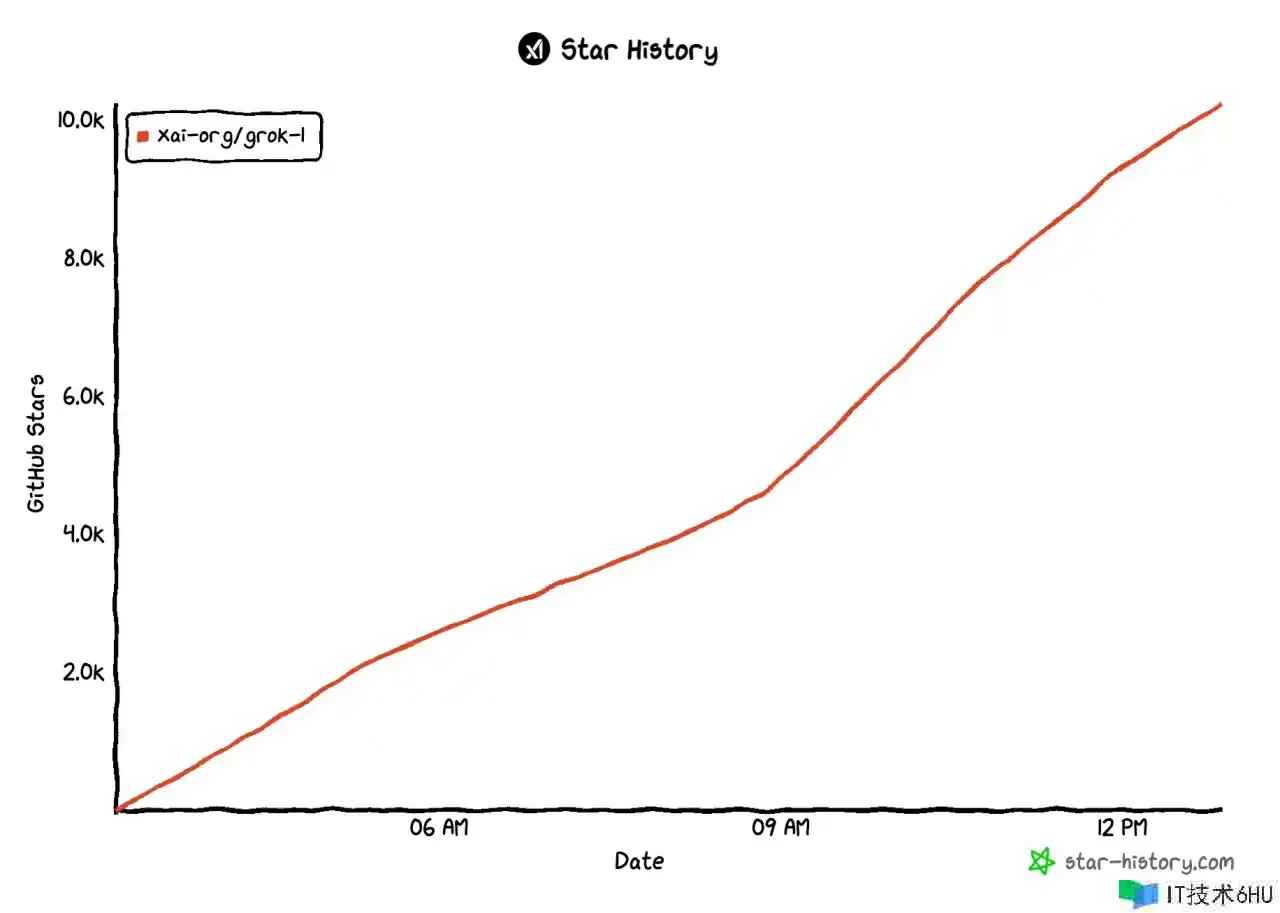

当时Grok-1已经在github上开源,并且正以一种难以置信的热度蹿升,马斯克真是在任何范畴都能带来巨大的流量。注意看下面star增长速度,是小时为单位的!现在才10多个小时,已经达到了10K star。

Github的仓库包含了用于加载和运转 Grok-1 敞开权重模型的 JAX 示例代码。

运转

pip install -r requirements.txt

python run.py

由于模型规划较大(314B参数),需要有足够GPU内存的机器才干运用示例代码测验模型。

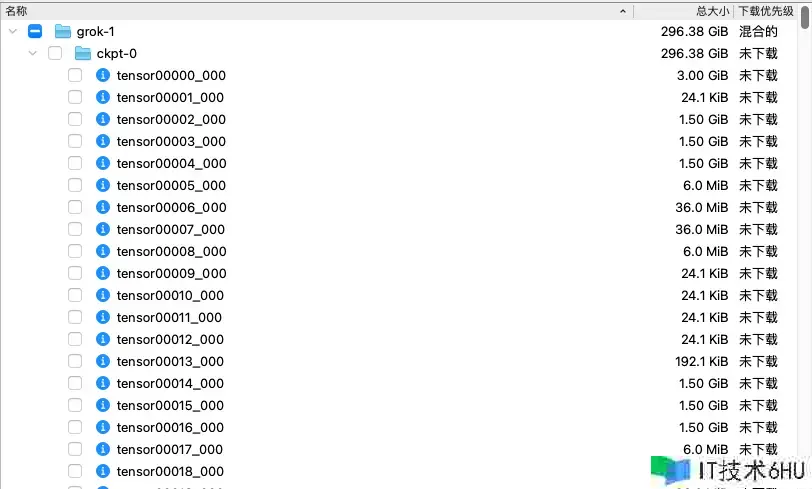

Github的仓库里也放出了模型下载的磁力链接,要着手测验的朋友们能够去下载了,296G的大小,大家要提早准备好空间。

xAI 表明,Grok-1 的研发经历了四个月。在此期间,Grok-1 经历了多次迭代。

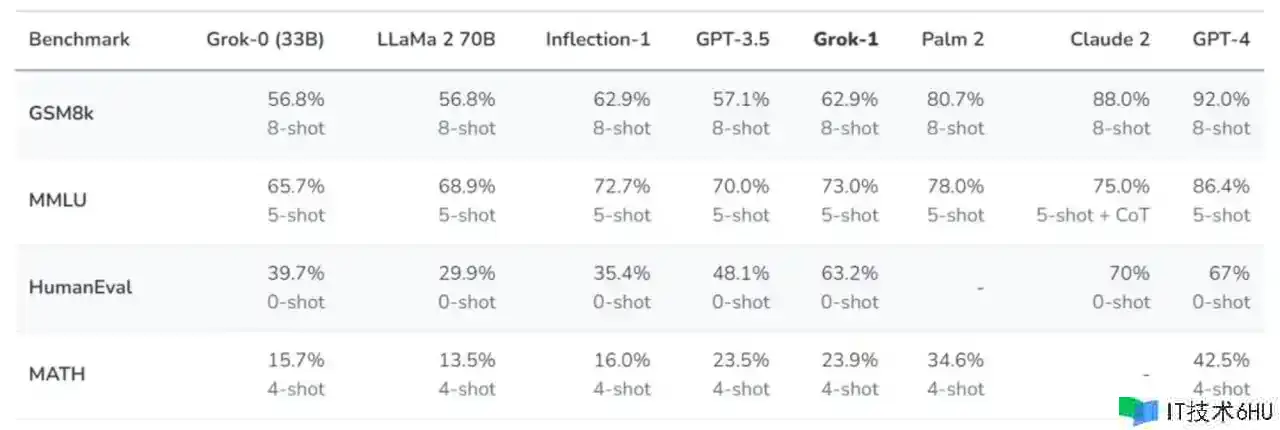

在发布了 xAI 创立的消息之后,他们练习了一个 330 亿参数的 LLM 原型 ——Grok-0。这个前期模型在标准 LM 测验基准上接近 LLaMA 2 (70B) 的才干,但只运用了一半的练习资源。之后,他们对模型的推理和编码才干进行了严重改进,最终开发出了 Grok-1,这是一款功能更为强大的 SOTA 言语模型,在 HumanEval 编码任务中达到了 63.2% 的成绩,在 MMLU 中达到了 73%。

xAI 运用了一些旨在衡量数学和推理才干的标准机器学习基准对 Grok-1 进行了一系列评估:

在这些基准测验中,Grok-1 显现出了强劲的性能,超过了其核算类中的所有其他模型,包括 ChatGPT-3.5 和 Inflection-1。只要像 GPT-4 这样运用很多练习数据和核算资源练习的模型才干逾越它。xAI 表明,这展示了他们在高效练习 LLM 方面取得的快速进展。

最近越来越多的科技巨子开端入局AI,纷繁发布自己的大模型,希望这能够让AI范畴更快速的开展,为人类带来更多的收益。