装置Ollama并运转

本地装置Ollama并运转

mkdir -p /data/

curl -fsSL https://ollama.com/install.sh | sh

>>> Downloading ollama...

######################################################################## 100.0%

>>> Installing ollama to /usr/local/bin...

>>> Creating ollama user...

>>> Adding ollama user to video group...

>>> Adding current user to ollama group...

>>> Creating ollama systemd service...

>>> Enabling and starting ollama service...

Created symlink from /etc/systemd/system/default.target.wants/ollama.service to /etc/systemd/system/ollama.service.

>>> The Ollama API is now available at 127.0.0.1:11434.

>>> Install complete. Run "ollama" from the command line.

WARNING: No NVIDIA/AMD GPU detected. Ollama will run in CPU-only mode.

运转大模型

装置完,即可 支撑命令行交互 对话

ollama run llama2

> 这时体系会主动下载对应的大模型文件。

pulling manifest

pulling 8934d96d3f08... 100% ▕██████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████▏ 3.8 GB

pulling 8c17c2ebb0ea... 100% ▕██████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████▏ 7.0 KB

pulling 7c23fb36d801... 100% ▕██████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████▏ 4.8 KB

pulling 2e0493f67d0c... 100% ▕██████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████▏ 59 B

pulling fa304d675061... 100% ▕██████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████▏ 91 B

pulling 42ba7f8a01dd... 100% ▕██████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████▏ 557 B

verifying sha256 digest

writing manifest

removing any unused layers

success

>>> hello

Hello! It's nice to meet you. Is there something I can help you with or would you like to chat?

>>> Send a message (/? for help)

大模型的models

- ollama.com/library

- 不同模型有不同版别,比方 llama2 有7b版别 需要3.8G内存 70b 需要39G内存。

- 这儿可以查看:

- ollama.com/library/lla…

装置运转70b版别模型测验

ollama run llama2:70b

经过Web拜访模型

不可能一向经过命令行交互完成chat

经过web控制台,相似chatgpt

更改Ollama运转形式

首先,修正Ollama运转形式为后端形式

screen

ollama serve

netstat -antp | grep ollama

装置open-webui依靠

装置docker「已装置则可选」

# docker 依靠

yum install -y yum-utils device-mapper-persistent-data lvm2 --skip-broken

yum install screen

yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

sed -i 's/download.docker.com/mirrors.aliyun.com/docker-ce/g' /etc/yum.repos.d/docker-ce.repo

yum makecache fast

yum install -y docker-ce

chkconfig docker on

service docker restart

service docker status

装置open-webui

用于在web交互ollama

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=http://172.31.130.74:11434 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

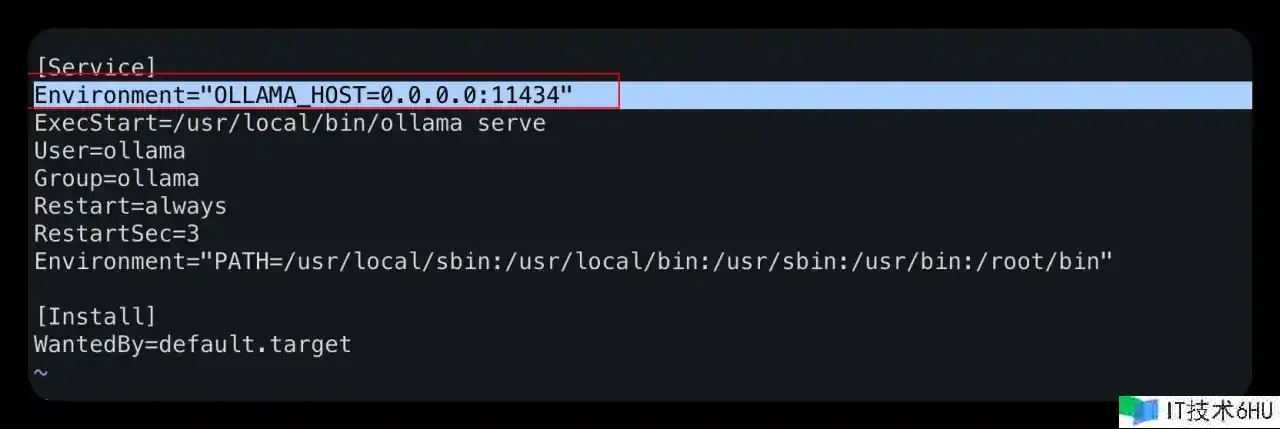

允许拜访open-webui API

vi /etc/systemd/system/ollama.service

增加

Environment="OLLAMA_HOST=0.0.0.0:11434"

systemctl daemon-reload

systemctl restart ollama

可能还需要开通防火墙 最终拜访 http://172.31.130.74:11434/api 即可

经过api拜访ollama

验证经过api可拜访ollama

curl http://localhost:11434/api/generate -d '{ "model": "llama2:70b", "prompt":"Why is the sky blue?" }'

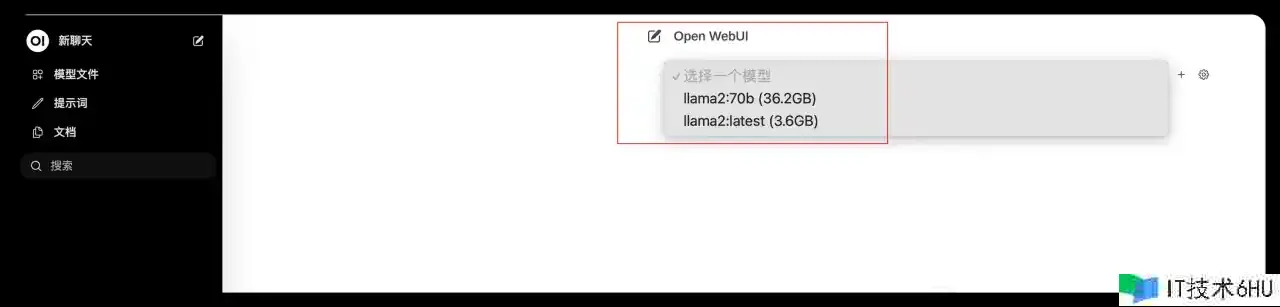

验证和拜访open-webui

拜访页面,注册账号。models列表可见即可。

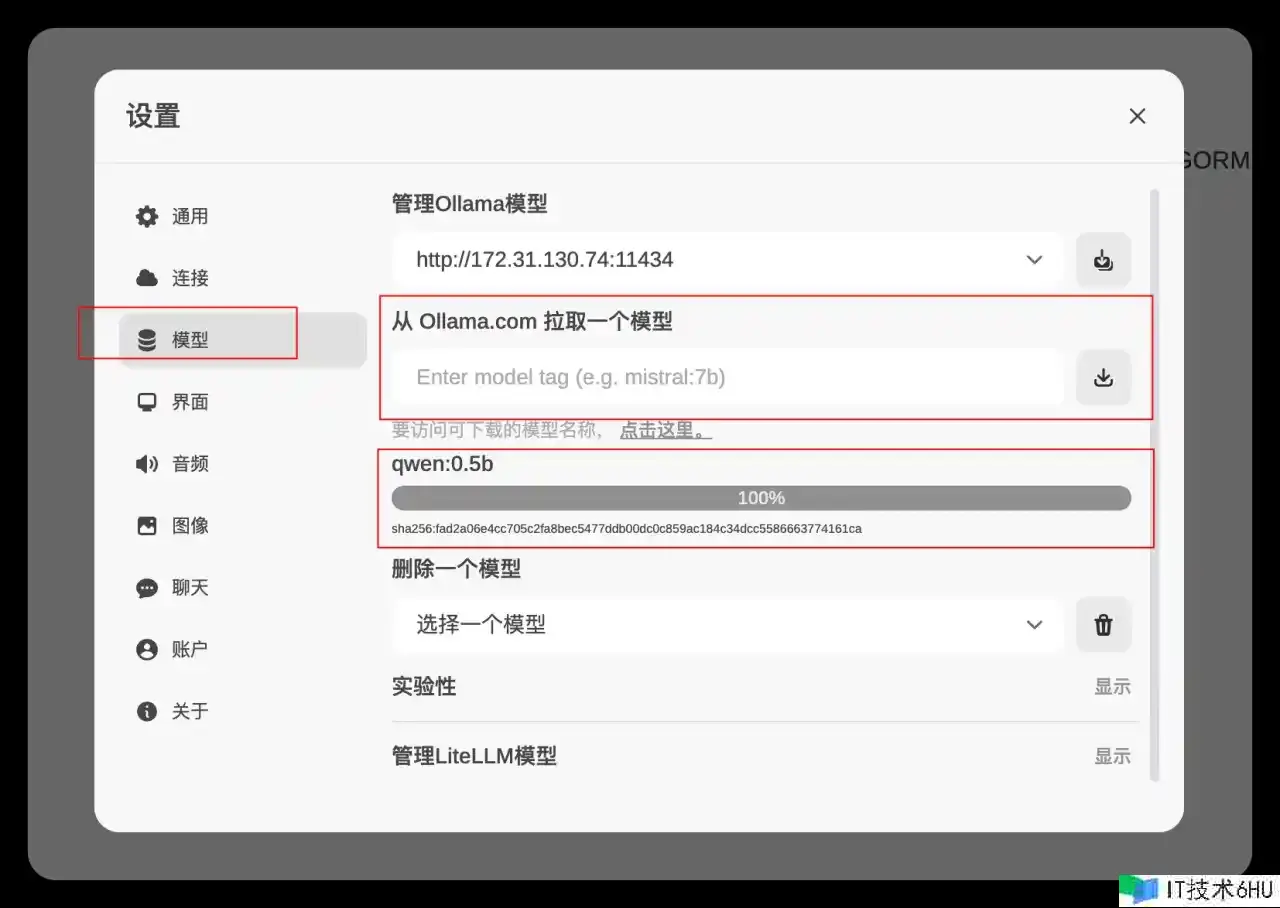

添加其他模型

Q&A

Models

「可选扩容磁盘」

阿里云在线扩容体系盘

# 第二步 在线扩容分区

fdisk -lu

Disk /dev/vda: 274.9 GB, 274877906944 bytes, 536870912 sectors

Units = sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk label type: dos

Disk identifier: 0x000c6592

Device Boot Start End Blocks Id System

/dev/vda1 * 2048 83886046 41941999+ 83 Linux

type growpart || sudo yum install -y cloud-utils-growpart

growpart is /usr/bin/growpart

sudo LC_ALL=en_US.UTF-8 growpart /dev/vda 1

CHANGED: partition=1 start=2048 old: size=83883999 end=83886047 new: size=536868831 end=536870879

# 第三步 在线扩容文件体系

df -Th

Filesystem Type Size Used Avail Use% Mounted on

devtmpfs devtmpfs 31G 0 31G 0% /dev

tmpfs tmpfs 31G 0 31G 0% /dev/shm

tmpfs tmpfs 31G 608K 31G 1% /run

tmpfs tmpfs 31G 0 31G 0% /sys/fs/cgroup

/dev/vda1 ext4 40G 25G 14G 65% /

tmpfs tmpfs 6.2G 0 6.2G 0% /run/user/0

sudo resize2fs /dev/vda1

resize2fs 1.42.9 (28-Dec-2013)

Filesystem at /dev/vda1 is mounted on /; on-line resizing required

old_desc_blocks = 3, new_desc_blocks = 16

The filesystem on /dev/vda1 is now 67108603 blocks long.

df -h

Filesystem Size Used Avail Use% Mounted on

devtmpfs 31G 0 31G 0% /dev

tmpfs 31G 0 31G 0% /dev/shm

tmpfs 31G 608K 31G 1% /run

tmpfs 31G 0 31G 0% /sys/fs/cgroup

/dev/vda1 252G 25G 218G 10% /

tmpfs 6.2G 0 6.2G 0% /run/user/0

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。