导言

本文为稀土技能社区首发签约文章,30天内制止转载,30天后未获授权制止转载,侵权必究!

集群,信任诸位对这个概念并不陌生,集群已成为现时代中,确保服务高可用不行或缺的一种手法。

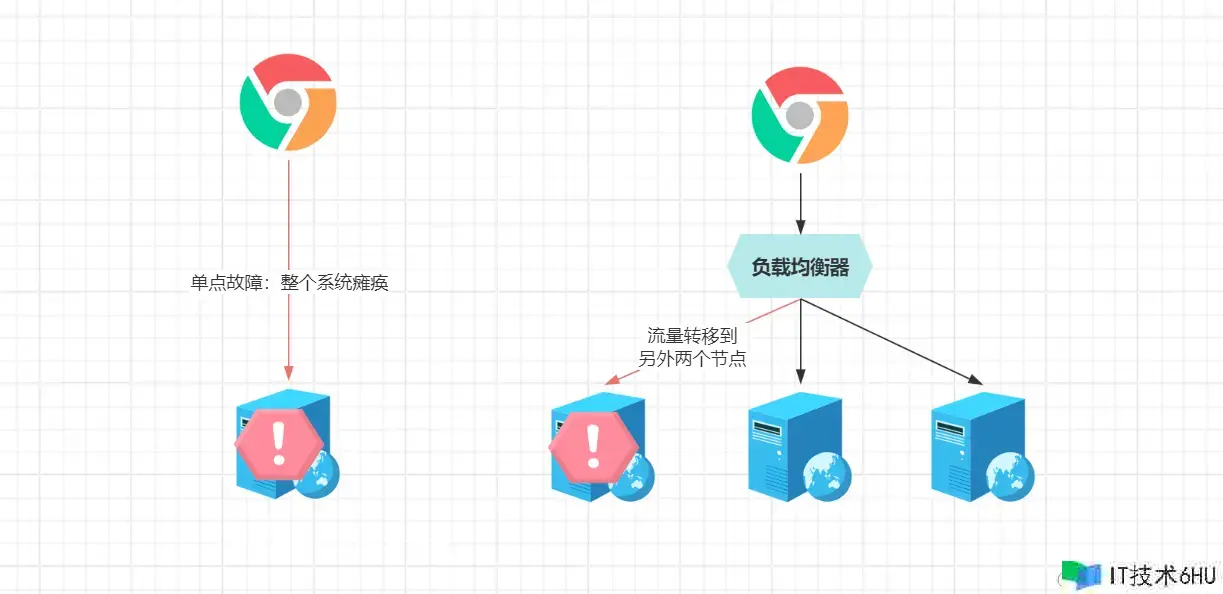

回想起初集中式布置的单体运用,由于只要一个节点,因而当该节点呈现恣意类型的毛病(网络、硬件资源、物理环境……)时,都会形成整个体系对客户端不行用,而这便是所谓的“单点毛病问题”。

单点毛病是建立高可用体系的第一道坎,而集群恰恰是处理单点毛病最有效的手法,就算体系内一个节点呈现毛病,仍旧有其他健康的节点能处理恳求,确保体系正常运转,完结99.999……%高可用。

许多人对集群的认知,都源自于Nginx,由于当程序功用跟不上事务需求、又不想对服务器升配时,就可以运用Nginx来加机器,运用多台“价格美丽”的低配机器,为服务做集群化布置,然后提高体系全体的吞吐量。

不过许多人对集群的认知止步于此,怎么完结PB级的海量数据存储?大部分人并不清楚,而本文则来详细聊聊集群的各方面常识,为诸位量身打造出结构化的集群常识体系。

PS:个人编写的《技能人求职攻略》小册已结束,其间从技能总结开端,到拟定期望、技能突击、简历优化、面试预备、面试技巧、谈薪技巧、面试复盘、选

Offer办法、新人入职、进阶提高、职业规划、技能办理、涨薪换岗、裁定补偿、副业兼职……,为咱们打造了一套“从求职到换岗”的一条龙服务,一起也为诸位预备了七折优惠码:3DoleNaE,感兴趣的小伙伴可以点击:s.juejin.cn/ds/USoa2R3/了解概况!

一、集群的界说与分类

集群,即是指:经过多台物理机器,组成一台逻辑上的巨大机器运用,集群带来的优势有四:

- ①高可用:集群内某个节点毛病,可迅速将流量迁移至其他节点,处理了单点毛病;

- ②吞吐量:多台机器并行处理外部恳求,可以为体系带来更强大的负载与吞吐才能;

- ③拓展性:可依据事务的增长/萎靡,动态弹性集群内的节点数量,体系愈加灵活;

- ④性价比:无需花费更高的价格升配机器,可运用多台价格、装备较低的机器构建。

集群带来的优点许多,即处理了单点毛病,又统筹了吞吐与功用、动态弹性、性价比,一起对客户端是无感知的,客户端在恳求时,无法分辨出究竟选用了多少台机器来布置服务。

上面是集群的底子界说与优势,现在问咱们一个问题:从性质维度动身,你以为集群可以分为哪几种?

1.1、集群的分类

集群咱们很熟,但一问集群的分类,估量各位会愣住,这……我没想过啊~

其实集群可大略分为两大类,逻辑处理集群、数据存储集群,前者对应着事务体系,后者对应着数据存储组件,举些比方阐明:

- 逻辑处理型集群:事务服务、

API网关、恳求分发器、并行运算(科学核算)服务等; - 数据存储型集群:缓存中间件、音讯中间件、数据库、查找中间件集群、对象存储等。

仔细观察下,假如了解云技能的小伙伴会发现,这跟云渠道里界说的有状况、无状况概念很类似~

简略来说,逻辑处理型的集群,只需求处理客户端恳求的逻辑运算,拿事务体系来说,现在有个登录功用,体系只需依据事务流程,执行完对应的事务逻辑,接着就可给客户端呼应成果。

PS:为了便于后续叙述,逻辑处理型集群则用事务体系来替代,当说到事务体系时,可主动代入“逻辑处理型集群”。

而存储型的集群,客户端一般是“程序”,如DB、Redis、MQ、ES……,生产环境里,处理的绝大多数恳求,都来自于事务体系。对于客户端的恳求,需求保存信息,处理写入恳求需求将客户端带来的数据存好,处理读取恳求则需将之前存好的数据拿出来回来。

当然,有人也许会疑问,事务体系不也是读写恳求吗?为什么将其归类到逻辑处理型?这是由于事务体系本身不会存储任何信息,客户端(用户)提交的数据,会由事务体系直接调用各类组件来存储,如登录信息放到Redis、事务数据放到DB……。

1.2、逻辑处理型集群的中心

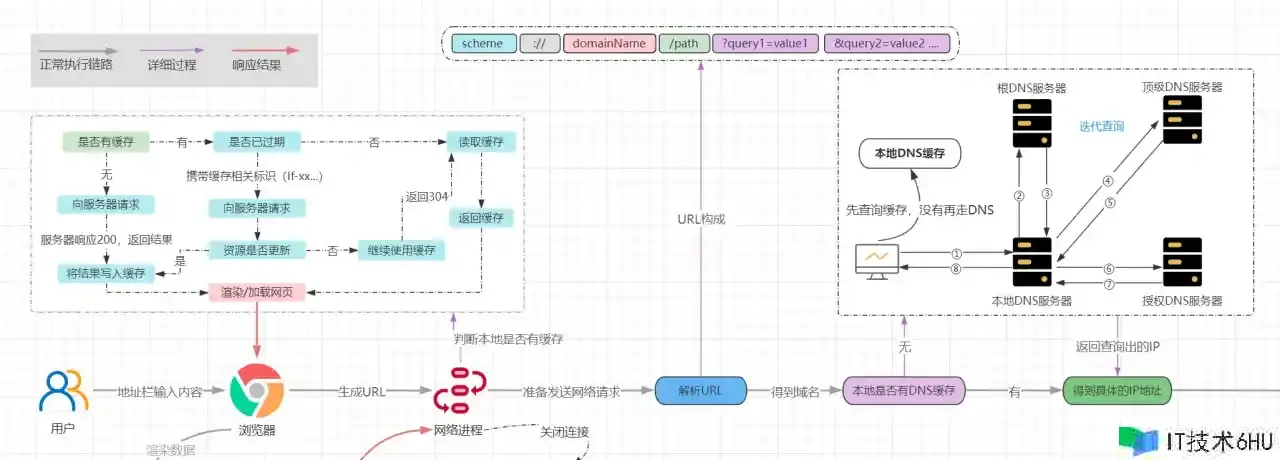

在之前的形式中,由于只要一台机器,域名可直接映射服务器的公网IP,当呈现对应域名的恳求,DNS可直接解析到对应的服务器IP,客户端(如浏览器)直接对拿到的IP建议恳求就行。

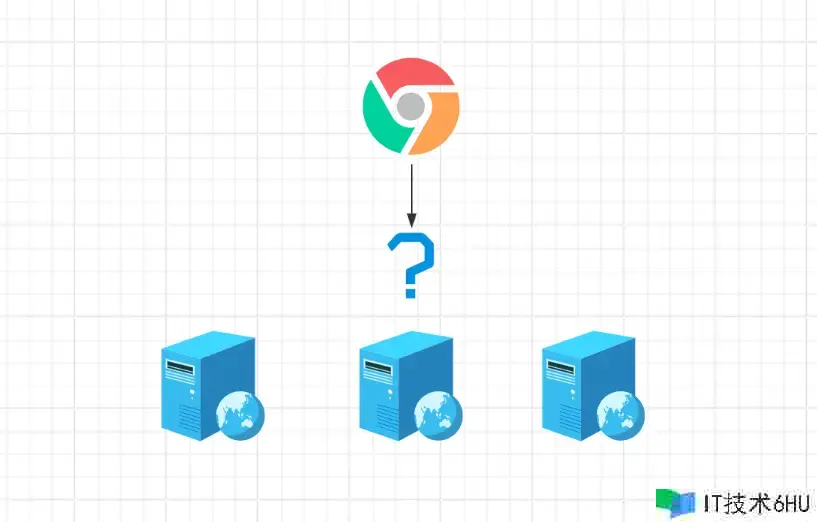

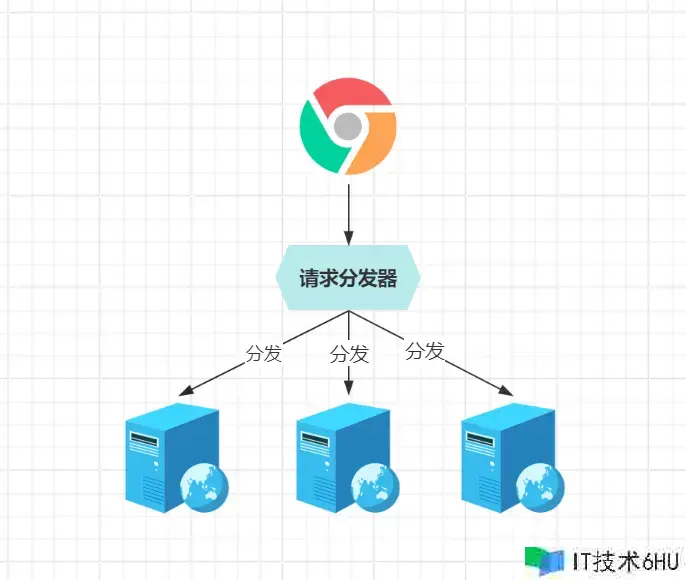

但是当一个事务体系,运用多个节点布置组成集群时,所面对的最大问题,即是恳求怎么分发到详细服务器?

为了处理该问题,不得不引入恳求分发器,域名映射恳求分发器所在的IP,分发器接到客户端的恳求后,再分发给详细的事务节点处理。

当外部恳求来到分发器时,分发器可以在已装备的节点列表中选一台机器,担任处理详细的事务恳求逻辑。但这儿有个问题,怎么确保各节点的负载均衡呢?随机分发貌似不太合适,咋办?挑选合适的分发算法,如轮询。

所谓的轮询,则是依据装备的节点列表顺序,依次分发恳求,如第一个恳求给第一个节点、第二个恳求给第二个节点……,当分发到最终一个节点时,再回到第一个节点,周而复始。听起来不错对吧?但有个问题,来看比方。

现在有个房子要装修,打电话定了一车水泥,一共六十包,现在有四个人在场:30岁的男人、9岁的儿子、30岁的老婆、60岁的老爹。

这儿的水泥便是恳求,依照轮询算法,六十包、四个人,你一拍大腿!正好一人十五包,合理不?明显不合理,先不说别的,光看九岁儿子那小身板,像个能抗十五袋的人不?

上述比方,换到集群场景中亦是同理,组成集群的机器有好有差,假如天公地道,站在那些较差的服务器来说,恳求分发的不够合理,因而该怎么确保分发的负载均衡?

负载均衡是两个词,负载即服务器现在承当的压力,均衡代表压力一起,组合起来便是指:集群内各节点承当的压力要一起!相同的访问量,分发到一台

2C4G服务器上,CPU利用率经常打到95%;但放到8C16G的机器上底子不是事。

综上所述,负载均衡要考虑各机器本身的功用,这时就得用到一些较为智能的分发算法,如:

- 平滑加权轮询算法:在轮询的基础上,依据机器装备,为各节点分配权重值;

- 最小活跃数算法:依据实践负载情况进行调整,主动寻觅活跃度最低的节点处理恳求;

- 最优呼应算法:依据分发后恳求的处理时刻,新恳求到来时,分发给呼应最快的节点处理;

- ……

这些智能化的分发战略,能综合考虑机器功用、实践负载、呼应速度等要素,挑选出相对合适的节点处理恳求,但这儿不做过多打开,感兴趣可参阅《网络编程-恳求分发篇》。

1.3、为什么分发器功用那么高?

事务体系做集群,通常会挑选Nginx,究竟它除开提供负载均衡的才能外,还能做反向署理,避免了将后端服务直接暴露在公网的隐患性,可为什么这类负载均衡器,功用那么高呢?

相同的访问量,Nginx可以轻松抗住,然后端服务或许要起几个才能勉强处理,为啥?其实道理很简略,由于这类负载均衡器,本身并不担任处理恳求,仅仅担任做恳求分发,所以用户的恳求,在Nginx里逗留的时刻极其短暂。

一台机器处理恳求的速度越快,在相同的时刻窗口里,其吞吐量更高。除此之外,由于不需求处理事务逻辑,天然也不存在资源之类的竞争(如锁资源),而且Nginx底层选用了多路复用模型,实践担任分发恳求的线程数很少,也不存在多线程运用那种线程上下文频频切换的开销……,种种要素下,为其高功用表现提供了强有力的支撑。

1.4、双机热备机制

作业年限较长的一点的小伙伴,应该在之前的招聘需求上,见过这么一条:

“具有集群、双机热备等高可用体系经验者优先……”

其间的双机热备技能是指啥?所谓的热备机制,可以了解成集群技能的特别表现,它是一种体系冗余设计计划,即一起布置两套体系,一主一备,主体系和备用体系并行运转。在主体系产生毛病时,备用体系能迅速接收主体系的作业,保持体系正常运作,以确保服务的可用性,及事务的连续性。

但是有了Nginx这类负载均衡器,还要啥热备技能呀?恰巧,便是Nginx这类组件需求热备技能支撑,虽然事务体系经过Nginx做了集群化布置,避免单点毛病形成体系不行用的危险,但Nginx就成了“咽喉要地”,由于它只要一个节点,假如布置Nginx的机器产生毛病,就会导致外部流量无法分发到事务体系,形成整个体系瘫痪。

热备机制怎么完结呢?可以借助keepalived、TurbolinuxTurboHA、Heartbeat这类专门确保高可用的技能栈完结,建造热备机制时要考虑几点:

- ①当进程呈现毛病(内存溢出、进程宕机等)时,热备机制能主动重启服务;

- ②当布置进程的机器呈现毛病(断网、停电、硬件损坏)时,备机能及时接替主机作业;

- ③新主上线接收后,旧主重新启动能主动成为新主的备机,确保热备机制的可持续性;

- ④呈现热备机制无法处理的毛病时(硬件问题、机房环境问题等),能及时告知人工介入。

做好上述四点,则代表热备机制较为完善,可详细咋做呢?这儿不过多赘述,感兴趣可参阅《Keepalived建立双机热备机制》。

PS:除一主一备外,也可以挑选建立双主热备,这样能最大程度利用资源,避免备机长时刻处于闲暇状况。

二、多形状的存储型集群

在上阶段,咱们简略聊了下集群的底子常识,以及快速过了一下逻辑处理型集群的内容,下面要点来看看存储型集群,究竟这块才是重头戏,集群的形状在其间有着多种多样的变化。

逻辑处理型的运用,布置集群架构是为了处理单点毛病、取得更高的吞吐量,集群内各节点之间没有依赖联系,一起遵循着“去中心化思维”,即多个节点里没有所谓的“老迈”。

反观存储型的运用,需求保存数据、记录会话数据、用户认证信息、事务状况等信息,假如要建立集群架构,则需求考虑各节点之间的数据一起性和完好性,来看个比方:

假定现在数据库运用三个节点组成集群,假如和事务体系集群相同,多个节点之间方位相等,此刻客户端读写数据时,究竟该去到哪个节点呢?包含多个操作的事务怎么确保落到同一节点?用户在A节点登录后,怎么把登录态(连接信息)同步给B、C节点?

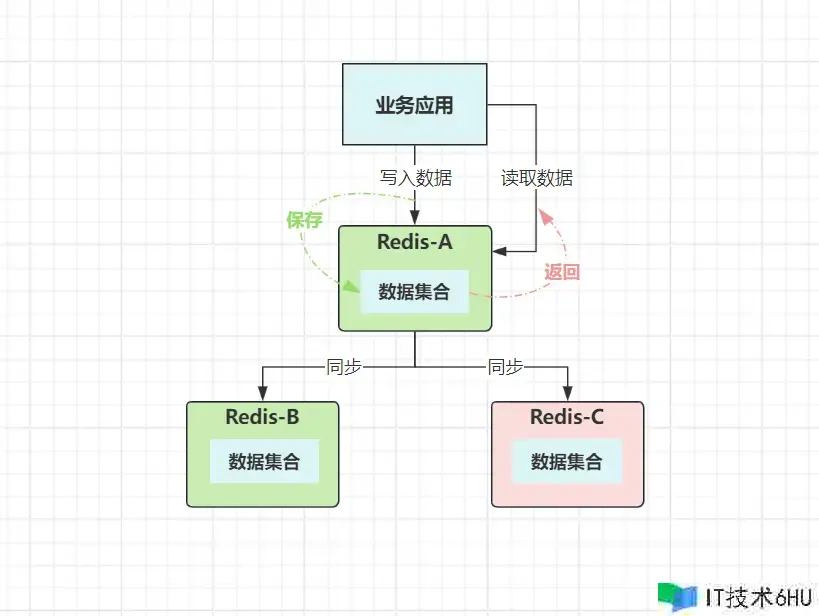

正是由于上述一堆的问题,存储型集群里的节点必需求划分等级,必定要有一个等级更高的节点,来承当客户端的写操作。因而,在很长一段时刻内,涉及到数据存储的运用,集群计划都是以主从形式为主。

趣事:主从形式对应的英文是

Master/Slave,不过咱们会发现,后来许多技能的主从形式,都叫Leader/Follower,这是为啥?由于Master/Slave代表的是“主人/奴隶”,再加上集群存在推举机制,所以在西方被痛斥为“此命名的政治思维不正确”,于是许多技能栈都经历过“言语净化”(如Redis)……

好了,上面说到主从集群,下面来打开聊聊存储型运用的集群计划,粗分下来也是两大类:

主从形式:集群内的节点区别等级,可以有一或多个主节点,具有完好的读写才能;也答应具有多个从节点,但才能方面有所阉割,只具有处理读取恳求的才能。

分片形式:集群内节点方位相等,各节点都具有数据读写才能,但每个节点只担任一部分数据,完好数据涣散在各节点上。

2.2、主从架构

主从集群,这个概念一切人都了解,它的身影在各种技能栈随处可见,如主从集群、镜像集群、仿制集群、副本集群……,虽然在不同技能栈的叫法不同,可本质上都是同一个东西。

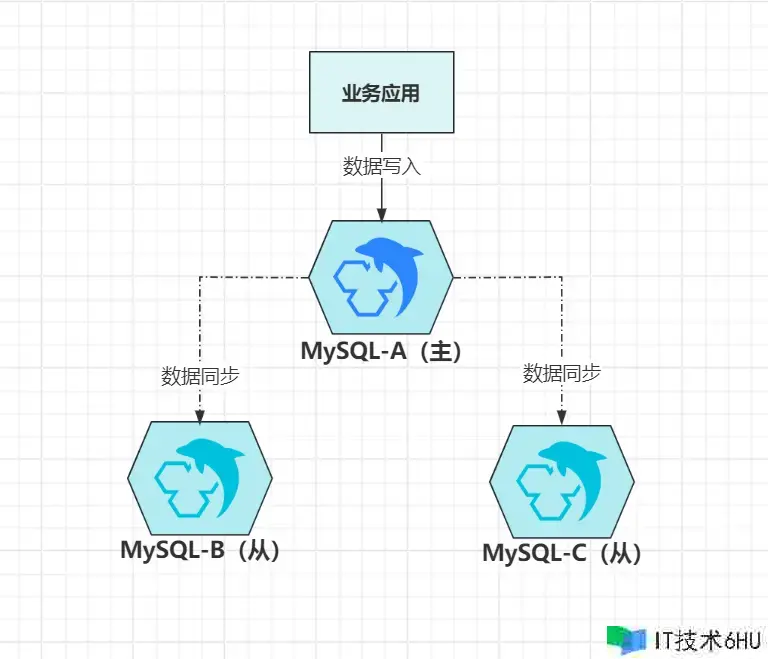

上图是经典的一主多从架构,客户端的写恳求,都会落到主节点A上,然后再给同步给B、C这两个从节点,这便是大名鼎鼎的“主从仿制技能”,数据同步有三种计划:

- 同步仿制:等数据写入集群一切节点后,再给客户端回来写入成功;

- 半同步仿制:等集群内一半数量以上的节点写入数据成功后,给客户端回来写入成功;

- 异步仿制:数据在主节点上写入成功后,立即给客户端回来写入成功。

大多数支撑主从仿制的技能栈,简直都上面三种同步计划,从数据一起性视点看:同步仿制>半同步仿制>异步仿制,而从功用视点动身则彻底相反:异步仿制>半同步仿制>同步仿制。

现在大多数技能栈默许的仿制计划都是第三种,虽然有数据丢掉的危险,但是它的功用最好,况且“主节点写入完数据,正好就产生毛病”的这种几率很小。当然,假如你的体系更在乎数据一起性和安全性,那就可以挑选半同步形式,假如彻底不在乎功用,则可以切换成同步仿制形式。

2.2.1、读写分离

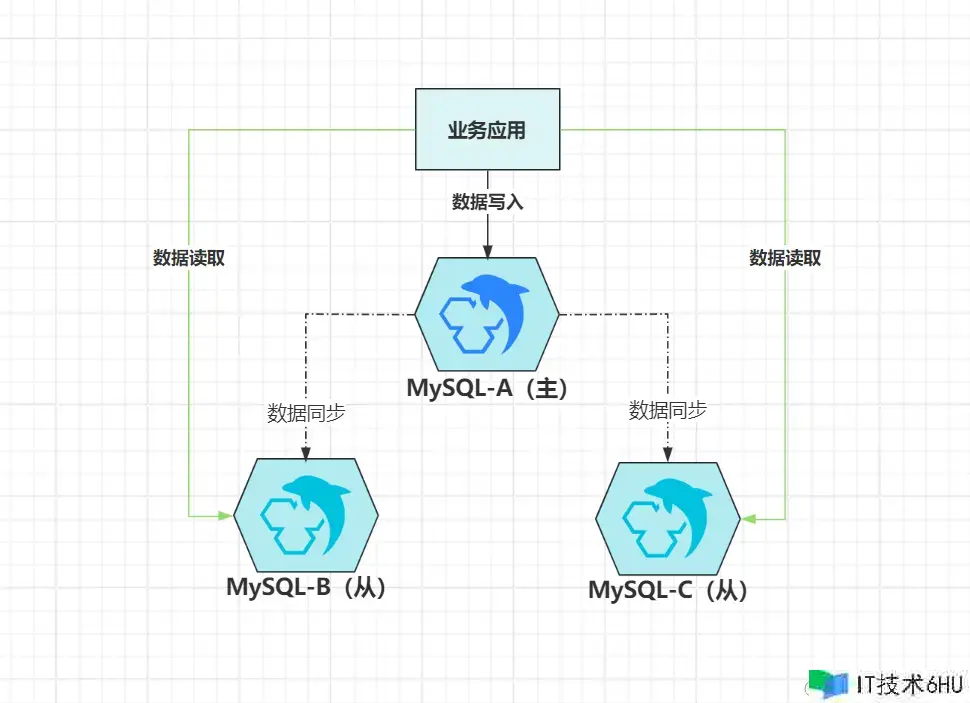

在主从架构中,由于从节点被阉割掉了处理写恳求的才能,所以在大部分时刻里,假如从节点只作为数据副本而存在,明显会形成很大的资源浪费。为了充分利用从节点的资源,一种名为“读写分离”的技能曾风靡一时。

虽然从节点没有处理写恳求的才能,但是它会把主节点写入的一切数据都同步过来,为此,它具有“必定程度”的读恳求处理才能,此刻就可以将读取数据的恳求分发给从机,既能充分利用闲暇资源,又能减轻主节点的访问压力。

PS:从节点只具有“必定程度”的读恳求处理才能,注意里面用引号标出的“必定程度”,这啥意思?

由于主从仿制技能,都依托网络来同步数据,而网络并不行靠,也必定存在推迟性。在异步仿制的形式下,当一个数据写入到主节点,立马呈现读恳求到从节点读取,此刻有可能读不到最新的数据。

2.2.2、毛病搬运

本文开篇说到的集群四大优势,其间一条则是确保了高可用,处理了单点毛病问题,可实践上部分技能栈,虽然支撑主从集群,但却只提供了底子的主从仿制功用(如MySQL),并不具有毛病搬运才能。

所谓的毛病搬运,通常是针对主节点而言的,即:当主节点产生毛病时,集群能主动推选出新主节点,并将流量主动搬运到新主处理。咱们熟知的MySQL,它并不具有主动毛病搬运功用,当本来设定的主节点毛病后,有必要经过人工介入、或第三方工具(如MHA),又或者自己研制的组件完结毛病搬运。

当然,也有许多技能栈,官方就完结了毛病搬运机制,比方Redis的Sentinel岗兵、MongoDB的Arbiter裁定者、Kafka的Controller控制器……,这些中间件的主从集群,在主节点产生毛病时,都能完结无人力介入、主动搬运作用。

这种主动毛病搬运机制,它们内部是怎么完结的?其实原理大同小异,毛病搬运的第一步,是需求能检测出毛病的节点,有两种计划可选:

- ①探测形式:担任毛病处理的节点,每隔一段时刻向集群一切节点发送探测包(

ping),没有回复的节点阐明现已毛病; - ②上报形式:集群内一切节点,主意向担任毛病处理的节点发送存活信息(心跳),当一个节点没有心跳时阐明堕入毛病。

不过为了兼容网络分区问题,通常会组合起来运用,正常情况下,集群节点主动发送心跳包,当某个节点没有心跳后,毛病处理节点会主动建议探测恳求,假如仍是没有回复,则会以为该节点堕入毛病。考虑到网络分区的影响,毛病处理节点也可能堕入了分区,因而也会向其他毛病处理节点,发出二次承认的恳求,以此进一步承认对应节点是否毛病。

PS:上述概念类似于

Redis岗兵里的主观下线、客观下线,一起也不仅仅只要毛病处理节点,具有毛病检测才能,集群内的节点也具有该才能,如从节点去拉数据时,也可以检测出主节点的健康状况。

假如本次检测出的毛病节点是主节点,则会进入新主推举流程,推举一般是经过投票机制完结,新主就任的前提是“节点数一半以上的票数”;而投票机制的内涵逻辑则是数据POS点,即谁的数据更新则更有机会成为新主,全体流程如下:

- ①毛病检测:当感知到某个节点不行用时,会先建议通讯向其他可用节点进行二次承认;

- ②毛病处理:假如检测到主节点不行用,从节点会将自己转换为候选人,并向其他成员宣告;

- ③推举开端:次序号加一,敞开一轮新的推举,每个候选人节点开端向其他成员发送拉票恳求;

- ④投票开端:在一个新的推举次序中,每个节点只能投一票,可以投给自己或者其他节点;

- ⑤投票结束:一切节点已投票,或抵达本轮推举的时刻约束后,将取得大多数投票的节点立为新主;

- ⑥主从切换:新主会向其他节点发送“上位”音讯,其他节点更新自己的装备,接受新主上位;

- ⑦数据同步:完结主从切换后,从节点以新主为数据基准,校验本身数据是否完好,有缺失则同步。

上面仅仅大约流程,但简直一切技能栈完结的思路都是这样,由于它们都遵循着Paxos、Raft等协议拟定的标准,本文对此不做打开,后续会单开华章来聊,咱们对详细进程感兴趣,可参阅《MongoDB裁定机制原理》或《Redis岗兵机制原理》。

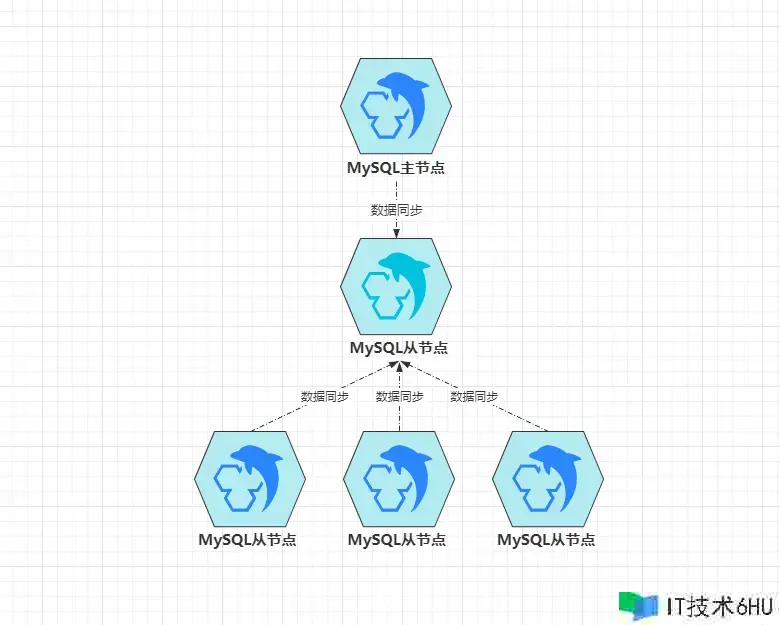

2.2.3、级联仿制

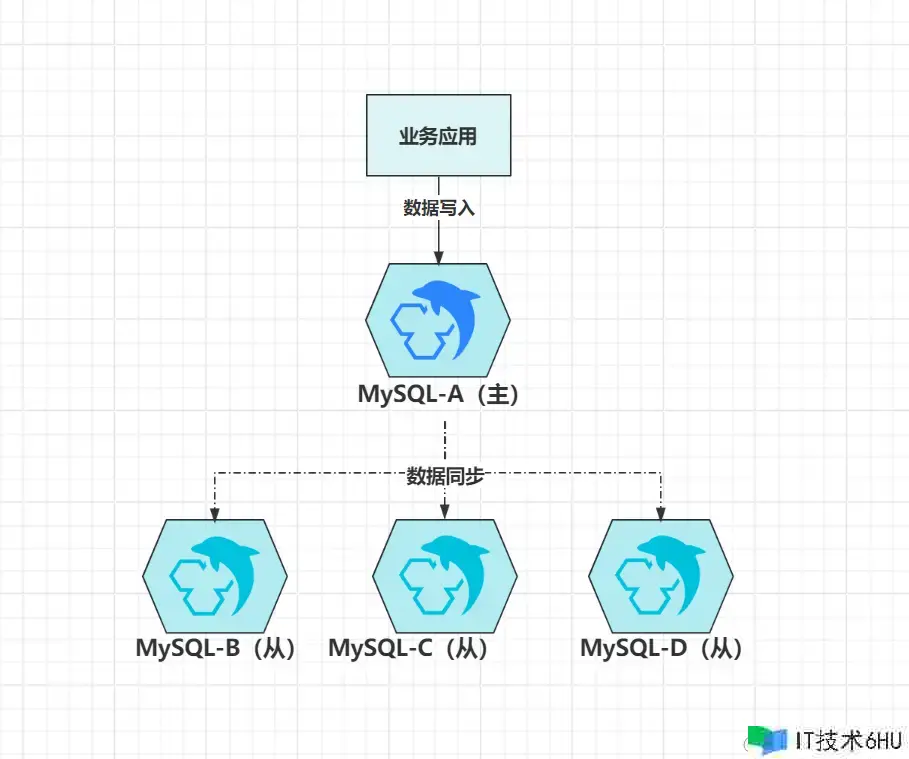

级联仿制是主从架构的变种,其本质仍是主从模型,主要用于一主多从的结构中,如:

在主从架构中,想要完结数据同步有两种方式:

- 主节点推送:当主节点呈现数据改变时,主意向本身注册的一切从节点推送新数据写入。

- 从节点拉取:从节点定期去问询一次主节点是否有数据更新,有则拉取新数据写入。

但不管是哪种方式,都会存在一个问题:主节点同步数据的压力,会随着从节点的数量呈线性增长!啥意思?由于不管是推仍是拉,数据都需求从主节点出站。

对主节点来说,数据同步会对磁盘、内存、带宽、CPU带来不小压力,此刻多一个从节点,天然多出一倍的压力,数据量较大时,特别容易把主节点的资源占满,然后形成主节点无法处理客户端的恳求,级联仿制的呈现,便是为了处理此问题。

级联仿制形式中,只要一个从节点B挂在主节点A下面,其他的从节点都会成为B的从节点,数据由B先同步到本身,其他节点再从B去同步数据,这样就处理前面的问题,可此刻又会带来新问题:

- 数据推迟:本身主从仿制就存在推迟性,而新加入一层后,数据推迟性会更高;

- 级联节点毛病:担任同步主节点数据的

B一旦毛病,会导致其他从节点无法同步数据。

凡事有利必有弊,虽然级联仿制能处理本来的问题,但是也会带来新问题,这时就需求处理新的问题,或者把新问题的影响降到最低。

PS:用来同步数据的

Canal中间件,就类似于级联仿制的思维。当然,除开小部分特别的项目,一般很少用到级联仿制形式。

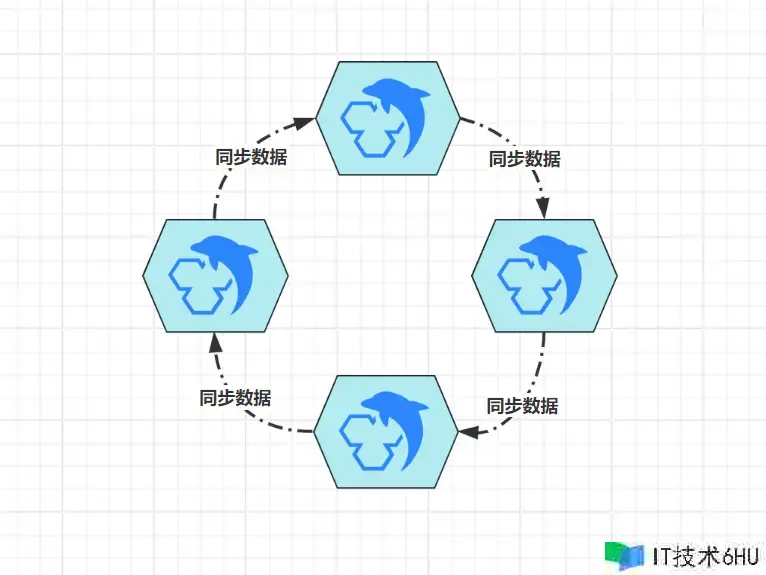

2.2.4、多主热备

虽然可以经过读写分离、级联仿制,减轻主节点的部分压力,可对于写恳求,都有必要得落到主节点上处理,而主节点再强悍,总有扛不住的时候,这时又呈现了变种集群:双主/多主形式。

多主形式也是建立在主从仿制的基础之上,比方双主形式时,两个节点互为主从,各自都具有完好的读写才能,客户端的写恳求,可以落入恣意节点上处理。不管数据落到哪个节点,另一个节点都会将数据同步过去,此刻客户端的读取恳求,在恣意节点上都能读到数据。

经过这种计划,可以将写入功用翻个倍,而且可以继续拓展出更多的主节点,组成多主集群。不过一般是双主,由于大部分技能栈支撑的主从集群,仅答应为一个从节点装备一个主节点,在这个约束下,想要完结多主,则只能组成环形多主集群:

这种环形多主架构,由于每个节点都支撑写入数据,所以能极大提高写入吞吐量,但成也萧何败也萧何,一个节点写入新数据后,需求经过N次(节点数量-1)仿制,才能将数据同步给一切节点,集群内的推迟性很高,这也是为什么一般只建立双主的底子原因。

PS:多主集群除开能提高写入吞吐量外,只要客户端略加适配,就可以完结“客户端版毛病搬运”,即客户端检测到一个节点不行用后,主动切换到其他节点上读写数据。

2.3、分片架构

不管是开端说到的横向集群,仍是上面聊到的主从集群,本质上都是“克隆”多个具有完好功用的单机节点组合布置,虽然主从里的从节点功用有所阉割,可全体上仍是属于主节点的仿制体。

对事务体系这类运用而言,用多个克隆体组成集群没任何问题,这也是集群概念的标准思维,但对于存储型运用来说,就会呈现三个致命问题:

- 木桶效应:三个节点的磁盘容量为

512G、1T、1T,集群最大容量则为512G; - 写入受限:传统的主从集群,写入的吞吐量受单个主节点约束,写入的并发很难提高;

- 容量危机:主从集群经过升配存储

GB、TB级数据,但上升到PB甚至更高量级时无力。

为了处理木桶效应,有必要确保集群一切节点的资源装备一起,不然同步数据时存不下;为了处理写入受限,可以建立特别的多主集群,可这种形式数据推迟太大;为了存储海量数据,只能不断加硬件资源带来更大的存储空间……

主从集群有着天然的坏处,虽然可以经过特别手法环境,但无法彻底治愈“先天性的下风”,这种传统型的集群计划,不再适用于增长迅猛的体系(无法处理高并发与海量数据存储)。正因如此,存储型运用在设计集群形式时,做出了一个违背祖先的决定:将数据分区存储,已然一台机子存不下,那我就用多台机子存!

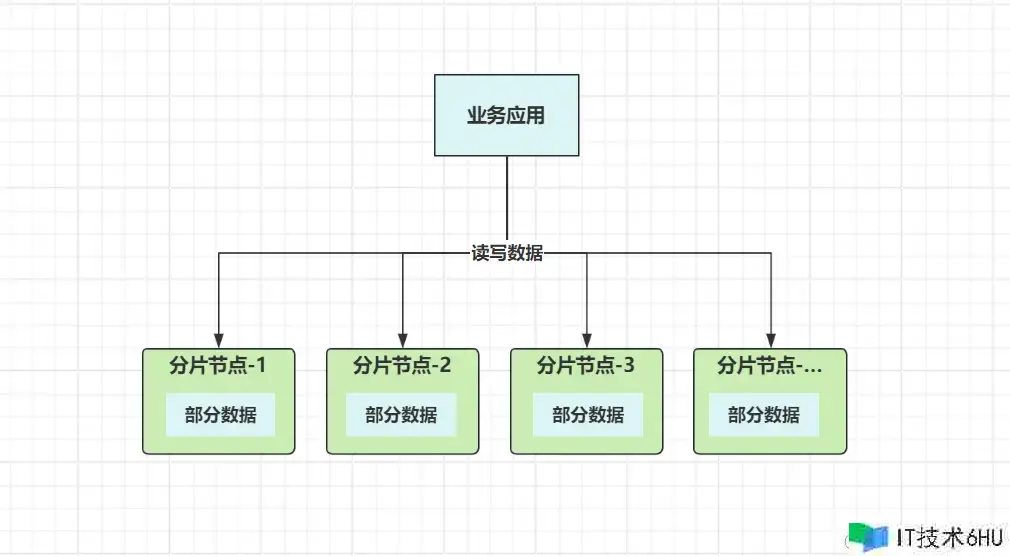

2.3.1、分片式集群

分区存储,便是现在大数据存储范畴大名鼎鼎的分布式存储技能,也叫:分片式集群,咱们再来好好聊聊这块常识~

之前的单体形式也好,主从集群也罢,数据其实都是集中式存储,即一切数据都存储在一起。分区存储,就相当于把本来的一缸水,分到不同的桶子里,如下:

每个分片节点,都具有读写数据的才能,这样就从底子上处理了写入瓶颈,而且数据涣散到多个节点独立存储,这并不受木桶效应的影响,处理了PB级数据存储形成的容量危机。

分片集群的优点许多,但想要完结分片式存储,首先要处理的便是数据路由问题,写入时能主动依据规矩落到某个分片节点存储,读取时能精准找到存储的分片节点获取数据。这和前面聊的恳求分发算法类似,只不过数据分发时,需求确保同一数据的写入/读取落入相同的节点。

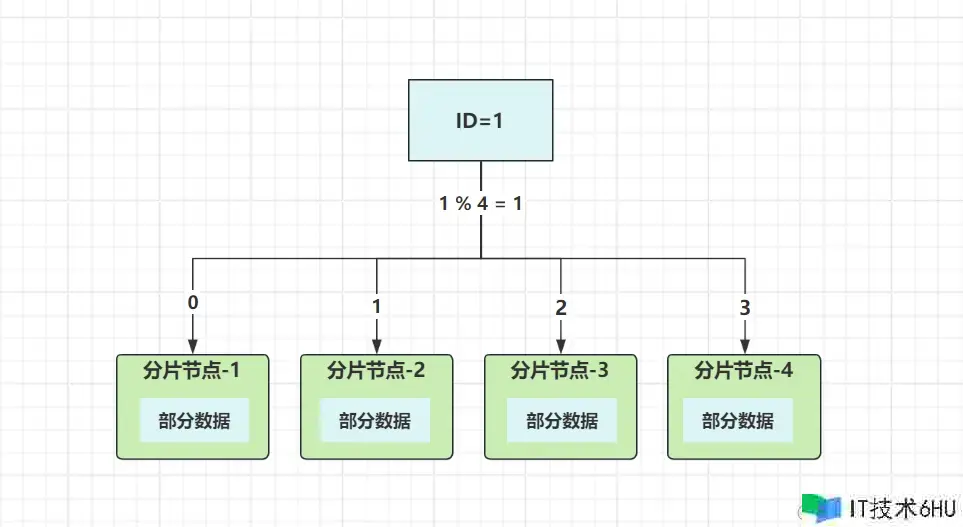

数据路由到详细的分片节点,有两个中心点,一是分片(路由)算法,二是分片(路由)键。数据分发和恳求分发不同,由于要确保同一数据读写都在相同节点操作,光靠分发算法无法完结,所以每条数据需求有个标识,这个标识便是路由键,以ID字段作为路由键来举例:

集群有四个节点,选用取模分发算法,依据ID值取模节点数量,核算出数据终究要落入的节点。来看实践进程,假定要操作ID=1这条数据:

- 写入:路由键

ID取模四:1%4,成果为1,数据落入分片节点2; - 读取:路由键

ID取模四:1%4=1,从分片节点2中读取数据。

经过这种方式,就确保了读写数据的节点一起,避免“写入成功,无法读取”的为难现象产生。不过除了取模分发外,还有其他一些分发算法,如规模分发、哈希取模、一起性哈希、哈希槽……,像Redis-cluster集群中,就选用CRC16算法核算Key(Key即路由键),并结合哈希槽形式完结数据分发。

处理了数据分发问题后,分片架构其实还存在一系列问题,比如多节点的数据怎么聚合等等。假如当前分片的存储组件属于联系型数据库,怎么兼容事务机制?多表联查怎么相关?怎么完结多字段维度查询?当然,其实还有一系列头疼的问题,这儿不做打开,感兴趣可参阅《分库分表副作用篇》。

经过上面的论述后,咱们必定对分片式集群有了底子认知,现在来聊聊分片集群的类型,全体可分两种:中心署理分片集群、去中心化分片集群。

2.3.2、中心化分片集群

中心化分片集群,意味着集群中又存在不同的角色节点,最少有两种:

- 中心节点:担任路由规矩、数据节点的办理作业,以及处理数据分发恳求,本身不存储分片数据;

- 数据节点:详细存储数据的分片节点,担任处理中心节点分发过来的写入/读取数据恳求。

上面的中心节点,就类似于之前的”负载均衡器“,担任办理集群一切节点,以及详细的分发作业,这种形式也是前期最干流的分片集群计划,即:署理式分片集群。

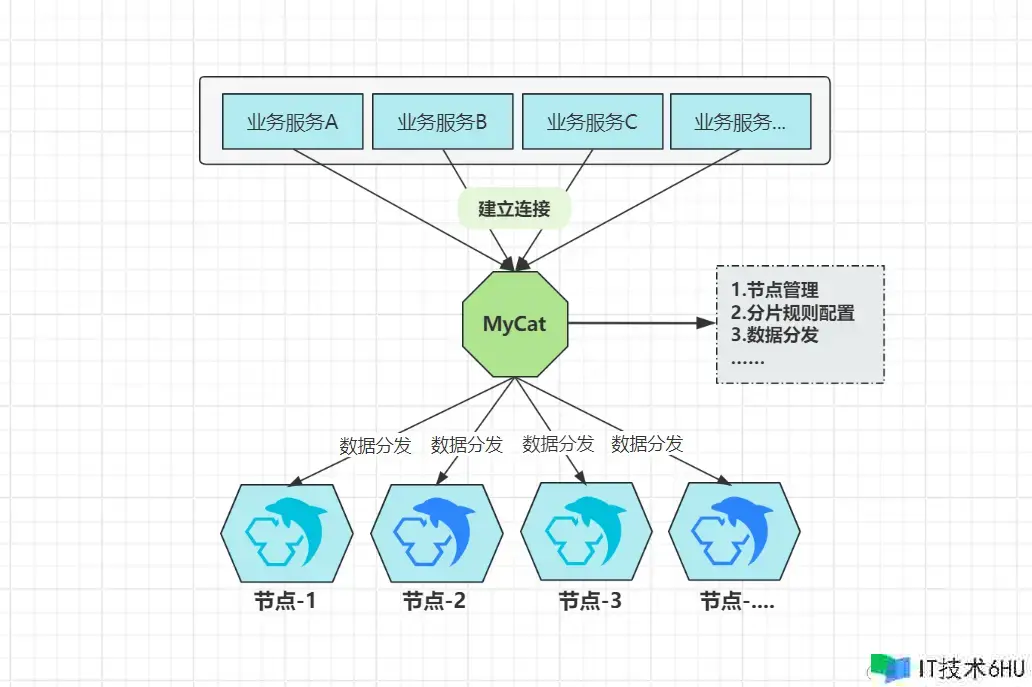

署理式分片,可以在官方不支撑分片集群的情况下,自己来建立分片集群,以传统联系型数据为例,MySQL官方并不支撑分片存储,怎么办?假如作业年限较长的小伙伴必定清楚,之前有个大名鼎鼎的中间件叫:MyCat,示意图如下:

虽然MySQL不支撑分片架构,但经过上述计划,可以将一个个独立的MySQL节点,组合成一个逻辑上的大全体,每个独立的MySQL节点,则代表着详细要存储数据的分片节点。MyCat则是担任节点办理与数据分发的中心节点,一切要操作MySQL的客户端,都会连接到MyCat,读写恳求交给MyCat做详细分发。

PS:实践

MyCat便是假装成了一台MySQL,事务体系仍旧和往常相同连接即可,屏蔽了客户端对分片集群的感知。

除开MyCat外,如同类型的Sharding-Proxy,又或者前期Redis的TwemProxy、Codis等等,这都是署理式分片理念的产品。究其底子,仍是由于前期官方并不支撑分片式架构,因而部分事务巨大的企业迫于无奈,只能在更高的维度上,架设中心节点来分发数据到不同的节点中存储。

这种中心化分片集群的思维,直到现在仍旧在运用,只不过现在很少有署理中间件,底子都由官方自己完结,如MongoDB分片集群,依托路由节点mongos进行数据分发。

为啥我称号这类分片集群为“中心化分片集群”呢?其实站在数据/分片节点的视点动身,节点之间彼此相等,不存在之前主从架构里的Master概念。但是,虽然没有了Master,但在数据节点之上有了一种更高维度的节点,一切数据节点都得“听”它组织,这便是一种特别的中心化表现。

中心化分片集群有何下风?特别明显,不管是第三方完结的署理中间件,仍是官方本身研制的“高等级节点”,究竟一切恳求都需经过“中心节点”,为此,一旦这类节点毛病,必定会形成整个分片集群不行用。

中心化分片集群,为了处理中心节点的单点毛病问题,一般都需求对中心节点做高可用建造,如

mongos集群式布置、MyCat做热备等等。

2.3.3、去中心化分片集群

与上阶段说到的中心化分片集群相反的,则是去中心化分片集群,典型的比方便是Redis3.x推出的Redis-Cluster集群,这是一种彻底意义上的去中心化集群,一切担任读写数据的节点方位相等,而且没有“中心化”的路由节点。

相反,Redis-Cluster中选用了哈希槽的概念,总计16384个槽位,集群初始化时会均匀分给每个节点担任办理(支撑手动设置),比方现在有四个节点,哈希槽的默许分配如下:

-

A节点:0~4095槽位; -

B节点:4096~8191槽位; -

C节点:8192~12287槽位; -

D节点:12288~16384槽位;

类似于之前0~15这16个默许的库相同,每个槽中都可以存放多个Key,一起配备CRC16哈希算法,终究完结数据的分发,例如下述命令:

set name zhuzi

则会运用CRC16算法对name这个键名进行哈希,接着取模总槽数16384,然后得出详细要落入的槽位。假定name对应的哈希值是185272,终究落入槽位则是5047(185272%16384-1),即落入到B节点中存储。

已然没有中心化的路由节点,那CRC16+取模运算的作业谁来完结?集群内的一切节点!在Redis-Cluster中,恣意节点都具有CRC16取模的才能,来看个场景:

假如一个本该落入

A节点的Key,在set时去到了C节点,那么C节点在经过CRC16核算后,会不会把该Key转发到A节点去呢?

答案是不会,而是会向客户端会回来一个重定向过错的音讯,其间指示了正确的节点方位,告知客户端去连接对应节点写入数据即可。

PS:实践项目中,并不会把

CRC16+取模的作业交给Redis来做,由于这样有可能会呈现一次重定向,通常都是客户端核算,然后直连正确的节点写入数据(如Java中干流的Redis客户端结构,都有完结CRC16的逻辑)。

好了,上述便是去中心化的大体逻辑,信任咱们必定理解为啥叫去中心化分片集群,由于不存在中心节点,各个节点本身就具有数据分发核算的才能,即便集群内部分节点宕机,也只会影响部分数据,确保了BASE理论中的底子可用思维,并不会像中心化分片集群那样,一旦中心节点毛病,就会形成分片集群不行用。

PS:分库分表范畴的

Sharding-JDBC,也是一种去中心化分片存储的表现,即各个客户端具有数据分发的才能,不需求依赖MyCat这类中间件完结数据路由。

相较于传统的主从集群,分片式集群的维度明显更高,当应对数据量级、并发规模非常大的体系时,分片式集群可以利用多台机器的一起满意数据需求,它能充分利用集群中每一台机器的资源,完结数据读写的并行处理,以及海量数据的分区存储。也正因如此,前期想完结分片式存储,需求自己研制中间件,反观现在,随着分布式各范畴技能的发展,分片式集群成为了新趋势,官方底子都开端支撑分片架构。

三、集群篇总结

OK,看到这儿,咱们一步步论述了集群中的常用常识,也对集群的形状有了全面认知,但本文并没有包含集群的方方面面,实践上,不同类型的集群架构,总会带来各式各样的问题,而这些问题并未做打开,也包含集群与云渠道的结合,本文也未曾阐明,这些就留给诸位自行去探索啦~

信任看到这儿的小伙伴,对集群方面的常识应该建立出了体系化、结构化的认知体系,不过经常阅览我文章的小伙伴会发现,本文中的许多概念,在以往的文章里都有提及,看起来会感觉反常了解,为啥?这便是我经常说的那句话:技能学到最终都是共通的,不同技能之间最终都能串起来。

不管是事务体系,仍是注册中心、守时使命、Redis、MQ、MySQL、ES……等各种组件,在完结集群计划时,底层逻辑都大差不差,本文则是各种技能栈集群方面的共通常识,当你在学不同技能栈的集群技能时,就会发现这些技能之间的共通性。

最终,也期望咱们不管在学习什么技能,不要只把目光集中在表层的运用,闲暇之余,记住看看内层的完结思维,这样方能做到一通百通,才能让咱们真正成为技能范畴的“高手”。

PS:后续一切文章会连续同步到个人大众号:竹子爱熊猫,想在微信上便捷阅览的小伙伴可查找重视~