前言

近年来,大型言语模型(LLM)在自然言语处理范畴取得了突破性进展。然而,随着模型参数量的不断增加,练习和布置成本也随之大幅进步,阻止了LLM的广泛使用。为了克服这一应战,混合专家模型(MoE)应运而生,它经过将模型拆分红多个专家并依据输入选择激活不同的专家来下降计算成本。DeepSeek-V2-Lite模型作为DeepSeek-AI团队最新发布的MoE模型,凭借其轻量级设计和高效的功能,为MoE模型研讨和使用开辟了新的方向。

- Huggingface模型下载: huggingface.co/deepseek-ai…

- AI 快站模型免费加速下载: aifasthub.com/models/deep…

技能特色

DeepSeek-V2-Lite模型采用了一系列立异技能,使其成为一个高效且易于布置的轻量级MoE模型:

- 多头潜在注意力(MLA)

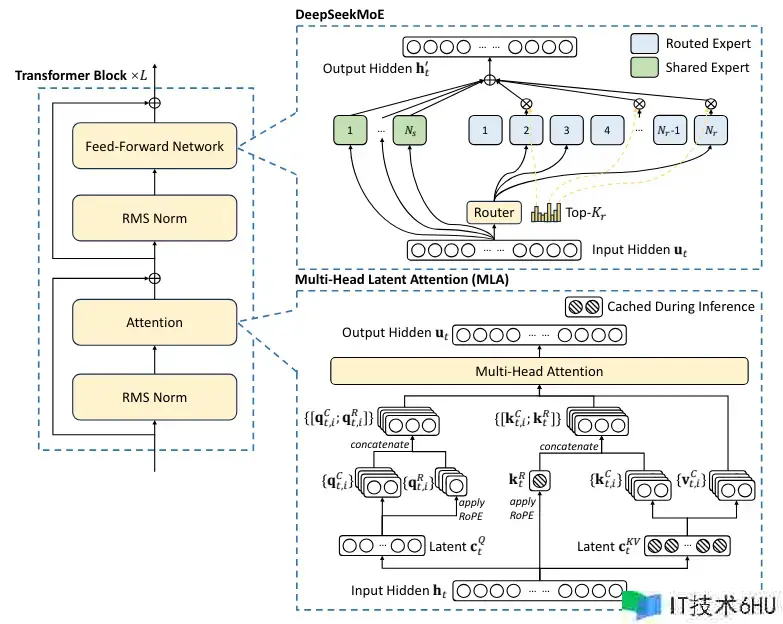

DeepSeek-V2-Lite模型采用了多头潜在注意力(MLA)机制。与传统的注意力机制不同,MLA经过将键值(KV)缓存压缩成潜在向量来大幅减少内存占用,然后进步推理功率。同时,为了进一步进步功能,DeepSeek-V2-Lite对查询和键进行解耦,并为每个注意力头设置了独立的维度,以进步模型的表达能力。

- DeepSeekMoE架构

DeepSeek-V2-Lite模型采用了DeepSeekMoE架构,该架构经过细粒度的专家分割和共享专家隔离来进步专家特化能力,并有效下降模型练习成本。在DeepSeekMoE中,每个MoE层包含共享专家和路由专家,每个token激活多个路由专家,然后完成模型的稀疏计算。

- 轻量级设计

DeepSeek-V2-Lite模型参数量为16B,但每个token仅激活2.4B个参数,这使得它成为一个轻量级的MoE模型。与DeepSeek-V2比较,DeepSeek-V2-Lite的参数量减少了近10倍,但功能却毫不逊色。

- 高效布置

DeepSeek-V2-Lite模型能够在单卡40G GPU上进行布置,这使得它更容易被使用于各种实践场景中。与需求更大内存的模型比较,DeepSeek-V2-Lite的布置成本更低,也愈加灵敏。

功能体现

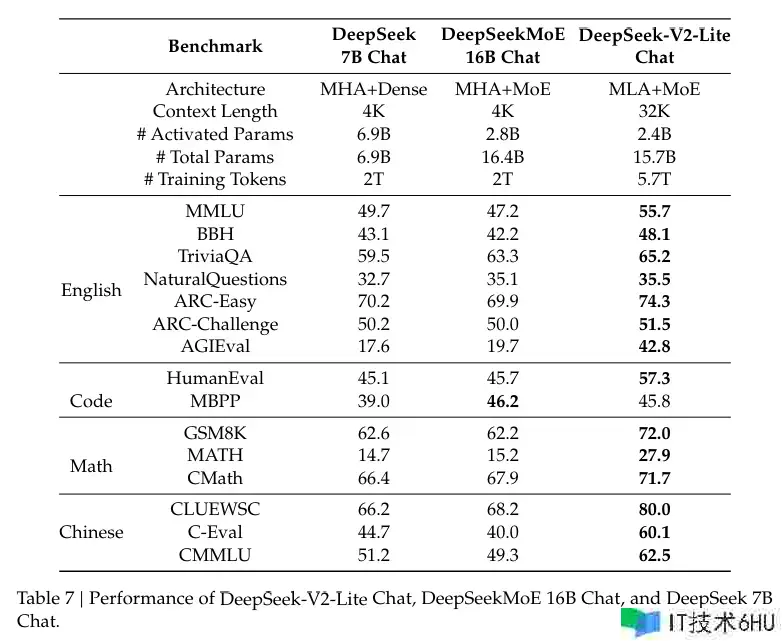

DeepSeek-V2-Lite模型在多个英语和中文基准测试中都取得了优异的功能:

- 在多个 基准测试 中,DeepSeek-V2-Lite的功能超过了7B密集模型和16B MoE 模型,展现出了其轻量化设计带来的功能优势。

- DeepSeek-V2-Lite模型在许多言语了解和推理使命中体现出色,例如问答、阅读了解、代码生成等,证明了其强大的多使命能力。

使用场景

DeepSeek-V2-Lite模型的轻量级设计和高效功能使其在众多使用场景中具有广阔的使用远景:

- 低资源场景: DeepSeek-V2-Lite模型能够用于练习和布置在资源受限的设备上的言语模型,例如移动设备、嵌入式体系等。

- 高效推理: DeepSeek-V2-Lite模型能够用于各种需求快速推理的场景,例如在线问答、机器翻译、文本生成等。

- 多使命学习 : DeepSeek-V2-Lite模型能够用于多使命学习,例如同时进行问答、翻译和摘要等使命。

总结

DeepSeek-V2-Lite模型的推出,标志着MoE模型研讨的重大进展。它证明了经过巧妙的设计和优化,能够构建出既高效又轻量级的MoE模型,并将其使用于各种实践场景中。相信DeepSeek-V2-Lite模型将为MoE模型的研讨和使用开辟新的方向,为人工智能范畴带来更多可能性。

模型下载

Huggingface模型下载

AI快站模型免费加速下载