爬虫处理途径建立

这是我参加8月更文应战的第16天,活动概况查看:8月更文应战

学习方针:

-

各爬虫处理途径了解

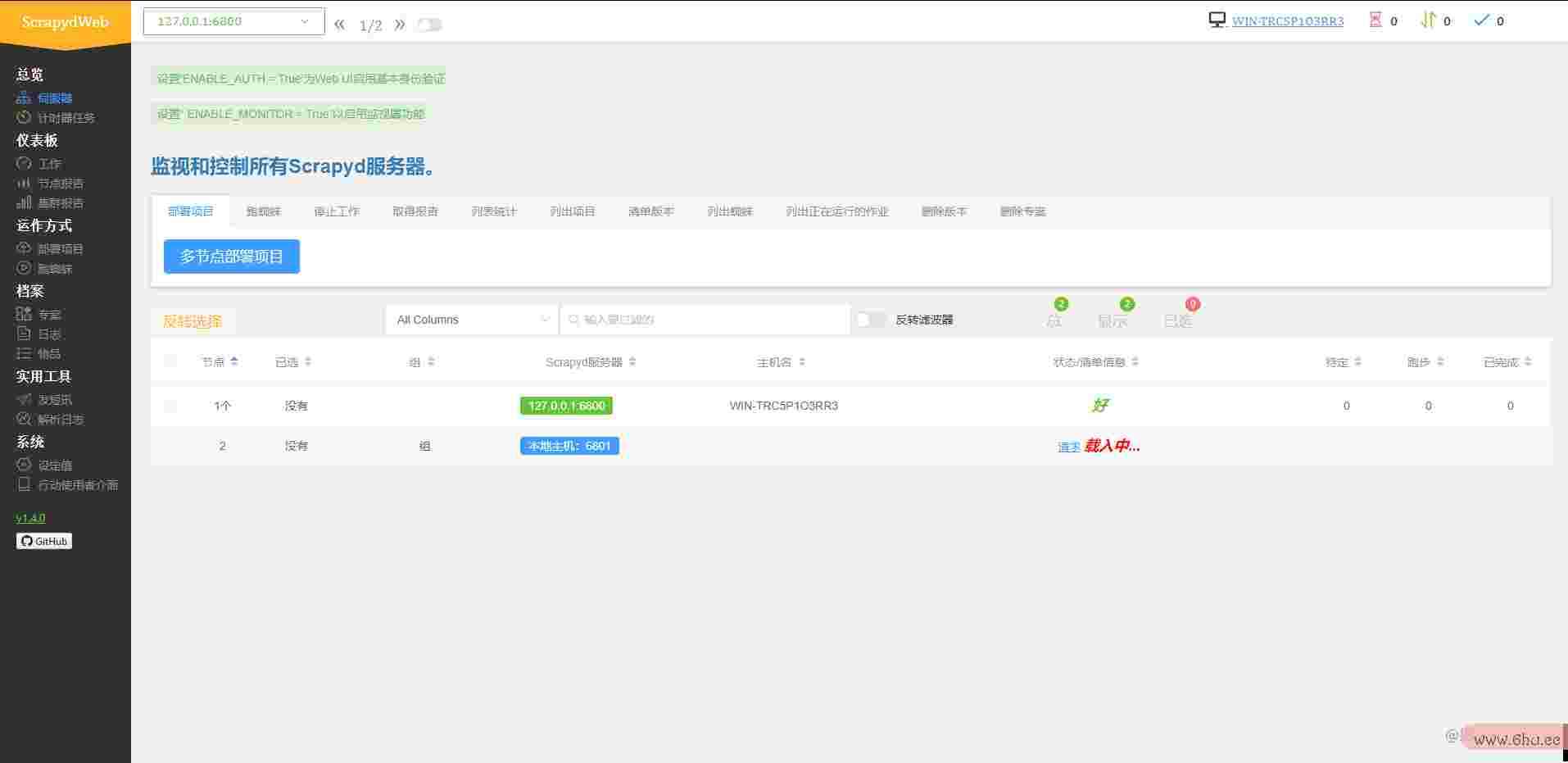

- scrapydweb

- gerapy

- crawlab

-

各爬虫处理途径的本地建立

爬虫处理途径了解:

-

sdjango结构crapydweb:

用于Scrapyd实施处理的web应用程序,支撑Scrapy日志剖析和可视化 github地址:https://github.com/my8100/scrapydweb.git -

gerapy:

依据Scrapy,Scrapyd,Scrapyd-Client,Scrapyd-API,Django和Vue.j教程英文s的分布式爬虫处理https安全问题结构 相关的装备在我之前博客地址:https://www.cnblogs.com/xbhog/p/13336651.html 该项目github地址:https://github.com/Gerapy/Gerapy.git -

crawlab:

依据Golang的分布式爬虫处理途径,支撑多种编程言语以及多种爬虫结构. 文档地址:https://docs.crawlab.cn/zh/ GitHub地址:https:/scrapy发音/github.com/crawlab-team/crawlab.git

留心:前两个结构的建立依据Scrapyd,假github官网设不知道怎样装备可以看我之前写的博客:www.c教程诀窍2nbloscrapy爬虫事例gs.com/xbhog/pgithub镜像/133…

爬虫处理途径的本地建立:

-

scrapydweb建立:

-

gerapy

- 相关的装备在我之前博github中文官网网页客地址:www.cnblogs.com/xbdjango装置教程hog/p/133…

-

crawlab:(装备设备官scrapy装置方给的很详细,这儿简略说下)

-

首先把代码从长途仓库clone下来:git closcrapy结构优缺点ne 地址/仿制地址到pycharm中

-

#官方推荐几种设备方式: Dohttps和http的差异cker(入门简略,推荐) Kubernetes(多机器安顿,推荐) 直接安顿(理解原理) 开发形式(开发调试) 多节点教程之家安顿 #个人选择docker,该项目django怎么读装备环境过多,怕给本地构成抵触 -

docker的设备:

- 设备地址:www.docker.com/products/do…

- 设备环django和flask的差异境:本地虚拟化以及hyper-V需求翻开,如图所示

-

默许设备即可

-

相关详细链接(菜鸟教程:www.runoob.com/https协议docker/wind…)

-

设备docker-compose包教程图片:pip install docker-compose

-

在https安全问题根目录下github中文社区检验:

docker-compdjango结构主要用来做什么ose ps 正常为空 Name Command State Ports ------------------------------ ------https安全问题-------------------------- -

设scrapy结构优缺点备并发动:docker-compose up -d

-

http://127.0.0.1:8080/#/login进入即scrapy教程可

-

完毕:

假定你看到这儿或许正好对你有所帮助,希望能点个关注或许推荐,感谢;

有过失的当地,欢迎在议论指出,作者看到会进行修改。

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

评论(0)