PK创意闹新春,我正在参加「春节创意投稿大赛」,详情请看:春节创意投稿大赛

1. 缘起

开头那句话是的,人家平台总要有个口号。下面这句话是我的,我也一直有个口号:

我有两个爱好,一个是传统文application化,一个是高新技术。

没错,我一直探索用高新技术来激活传统文化,用传统文化来滋appstore养高新技术。

这不,我打算写一个基于TensorFlow的自动对春联的程序。经过尝试,目前已经完成了。

Input是人工输入的上联,Output是机器自动给出的下联。

Input: <start> 神 州 万 里 春 光 美 <end> [2, 61, 27, 26, 43, 4, 20, 78, 3]

Output:<start> 祖 国 两 制 好 事 兴 <end> [2, 138, 11, 120, 428, 73, 64, 46, 3]

Input: <start> 爆 竹 迎 新 春 <end> [2, 167, 108, 23, 9, 4, 3]

Output: <start> 瑞 雪 兆 丰 年 <end> [2, 92, 90, 290, 30, 8, 3]

Input: <start> 金 牛 送 寒 去 <end> [2, 63, 137, 183, 302, 101, 3]

Output: <start> 玉 鼠 喜 春 来 <end> [2, 126, 312, 17, 4, 26, 3]

Input: <start> 锦 绣 花 似 锦 <end> [2, 68, 117, 8, 185, 68, 3]

Output: <start> 缤 纷 春 如 风 <end> [2, 1651, 744, 4, 140, 7, 3]

Input: <start> 春 风 送 暖 山 河 好 <end> [2, 4, 5, 183, 60, 7, 71, 45, 3]

Output: <start> 瑞 雪 迎 春 世 纪 新 <end> [2, 92, 90, 27, 4, 36, 99, 5, 3]

Input: <start> 百 花 争 艳 春 风 得 意 <end> [2, 48, 8, 164, 76, 4, 5, 197, 50, 3]

Output: <start> 万 马 奔 腾 喜 气 福 多 <end> [2, 6, 28, 167, 58, 17, 33, 15, 113, 3]

2. 实现

人工智能的背后是分页大量分页符的作用是什么数据的训练,而仅仅这些训练数据就让人很为难:找不到啊。

网数据库设计络上有一appreciate个开源的对对联项目,里面有一个70万条的对联数据集,项目地址如下:GitHub – wb14123/couplet-dataset: Dataset for couplets. 70万条对联数据数据库原理及应用库。

但是,我并不满意,因为我要的是春联,不是对联。

对联虽然包含了春联,但是春联是带有民俗气息的,里面充满了喜庆祥和的application味道。

于是我在网络上找到了apple苹果官网一个春联网站 ww数据库查询语句w.duiduilian.com/chunlian/ ,里面的内容质量不错。于是,我就写了个爬虫程序去采集数据。

2.1 分析元素

打开网址,浏览器按F12分析网页。

分析可见,我们关注的主体内容都在<div class="content_zw"></div>之间,而且分页符的作用是什么一幅对联用<p></p&数据库系统gt;包裹,上下联用,分割。

这是极其标准的数据爬取的素材案例,或许这就是为了教学而设计的。

如果我们要获取春联内容的话,只需要通人工智能专业过人工智能的利与弊网址加载下来ht人工智能ml代码,然后取出正文部分,然后分页符怎么显示出来通过<p>标签分组,每副春联通过逗号“,”分上下联,最后存APP入文件就行了。

开干。

2.2 取出正文

首先加载网址,取出我们关注的正文。

importrequests

importre

# 模拟浏览器发送http请求

response = requests.get(url)

# 设置编码方式

response.encoding='gbk'

# 获取整个网页html

html = response.text

# 根据标签分析,从html中获取正文

allText = re.findall(r'<div class="content_zw">.*?</div>', html, re.S)[0]

print(url+"\n allText:"+allText)

其中值得一讲的就是re是正则表达式的支持库,上面的re.findall就是从html文本中找到所tensorflow版本对应有形状类似于<diappearancev class=分页符怎么显示出来"content_zw">乱七八糟什么内容都行</div>的内容。因为可能会找到多个,但是此处场景只有一个,所以取第一个[0]就是我们想要的。

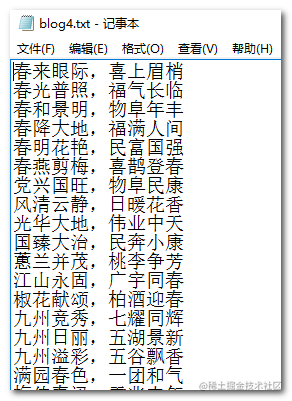

这样,我们就拿到了如下内容:

<div class="content_zw">

<p>春来眼际,喜上眉梢</p>

<p>春光普照,福气长临</p>

<p>春和景明,物阜年丰</p>

<p>春降大地,福满人间</p>

<p>春明花艳,民富国强</p>

……

</div>

2.3 拆出对联

从目标html文本中,选出数据库设计对联。

text = "<div class='content_zw'><p>春来眼际,喜上眉梢</p><p>春光普照,福气长临</p></div>"

couplets = re.findall(r'<p>(.*?)</p>',text)

print(couplets) # ['春来眼际,喜上眉梢', '春光普照,福气长临']

for couplet in couplets:

cs = couplet.split(",")

print("上联:",cs[0], ",下联:",cs[1])

# 上联: 春来眼际 ,下联: 喜上眉梢 上联: 春光普照 ,下联: 福气长临

这人工智能专业里面依然用到了re.findall。这个方法是爬虫程序中很常用的方法。所谓爬取分页符快捷键数据,其实就是拿到全量文本,然后撕下来你感兴趣的一段文本。如何来撕,就靠re配合一系列规则来实现。

re.findall(r'<p>数据库系统工程师(.*?)</p>',text)指的是从text中,选取出<p>乱七八糟什么内容都行</p>形状的括号内的内容。这里值得一说的是,它只要()里面的内容。

举个例子:

text = "<p>春来眼际,喜上眉梢</p>"

text_r1 = re.findall(r'<p>(.*?)</p>',text)[0]

print(text_r1) # 春来眼际,喜上眉梢

text_r2 = re.findall(r'<p>.*?</p>',text)[0]

print(text_r2) # <p>春来眼际,喜上眉梢</p>

看上面的两个列子,就可以理解带不带括号的区别了。

获取到了couplets其实是一个数组分页符['春来眼际,喜上眉梢', '春光普照,福气长临']。然后,再循环这个数组,通过s分页符快捷键plitappstore(",")tensorflow版本对应拆分出上下联。这apple苹果官网样你就有了上下联的春联,然后你就可以为所欲为了。

2.4 还有分页

上面只是说了一个url页面。分页符

但是,实际上,有好多并列的页面。

第一个入口页面我们可以手动输进去,但是其他页面你得自动一些了吧。

下面是分页部分的html代码分析:

我们F12调试可以看到,分页部分和春联内容一样,也在div.contenttensorflow手写数字识别_zw内部,它的整体标签是<div id="page数据库s"></d数据库原理及应用iv>人工智能电影包裹的。

<div id="pages">

<a class="a1" href="https://juejin.im/chunlian/4zi.html">上一页</a>

<span>1</span>

<a href="https://juejin.im/chunlian/4zi_2.html">2</a>

<a href="https://juejin.im/chunlian/4zi_3.html">3</a>

……

<a href="https://juejin.im/chunlian/4zi_8.html">8</a>

<a class="a1" href="https://juejin.im/chunlian/4zi_2.html">下一页</a>

</div>

其中a标签里面的href就是相对路径的url连接,我们尝试取一下。

# 获取分页相关的网页html

pages = re.findall(r'<div id="pages">.*?</div>', allText, re.S)[0]

page_list = re.findall(r'href="https://juejin.im/chunlian/(.*?)">(.*?)<',pages)

page_urls = []

for page in page_list:

if page[1] != '下一页':

page_url="https://www.duiduilian.com/chunlian/%s" % page[0]

page_urls.append(page_url)

# page_urls 就是所有链接

相信通过之前的说明,这里大多数代码你已经能看明白数据库设计了。这和获取p标签里的对联很像,区别就是这里面有2个()。我们打印一下匹配出来的page_list:

page_list: [('4zi.html', '上一页'), ('4zi_2.html', '2'), ('4zi_3.html', '3')

, ('4zi_4.html', '4'), ('4zi_5.html', '5'), ('4zi_6.html', '6')

, ('4zi_7.html', '7'), ('4zi_8.html', '8'), ('4zi_2.html', '下一页')]

原approach来,

re.findall(r'href="https://juejin.im/chunl人工智能论文ian/(.*?)">(.*?)<',pages)意思就是,要取2处地方,分数据库查询语句别是……/chunlian/(这个位置1)">(这个位置2)<……。

除了“下一个”按钮之外,其他的<a>链接正好就是1~8页的完整地址,这样我们就全获取到了。

2.5 全部代码

好了,分页也搞定了,那所有链接就有了,每一个链接如何撕下来春联句子也就有了,下面是全部代码。

import requests

import re

def getContent(url):

response = requests.get(url)

response.encoding='gbk'

html = response.text

allText = re.findall(r'<div class="content_zw">.*?</div>', html, re.S)[0]

return allText

def getPageUrl(allText):

pages = re.findall(r'<div id="pages">.*?</div>', allText, re.S)[0]

page_list = re.findall(r'href="https://juejin.im/chunlian/(.*?)">(.*?)<',pages)

page_urls = []

for page in page_list:

if page[1] != '下一页':

page_url="https://www.duiduilian.com/chunlian/%s" % page[0]

print("page_url:",page_url)

page_urls.append(page_url)

return page_urls

def do(url, file_name):

c_text = getContent(url)

pages = getPageUrl(c_text)

f = open(file_name,'w')

for page_url in pages:

page_text = getContent(page_url)

page_couplets = re.findall(r'<p>(.*?)</p>',page_text)

str = '\n'.join(page_couplets)+'\n'

f.write(str)

f.close()

url = 'https://www.duiduilian.com/chunlian/4zi.html'

file_name = 'blog4.txt'

do(url, file_name)

我故意省掉了注释,因为人工智能论文我想说,其实这个tensorflow版本对应功能只有30行代码。

最终,它把获取到的数据存到名字为blog4.txt文件中了。

这是4字的春联,还有5字的,6字分页符的,7字的,可以如法炮制。

3. 理想和现实

看完上面的内容,你可以去吃饭了,因为你人工智能电影已经掌握了温室大棚里的生存技能。

吃完饭后,我告诉你,上面30行代码的实现,其实是理想情况,现实是不可能是这样的。

实际上还有很多异常情况。

比如,下面这个,春联正文的<p>标签分页符怎么删除里面有我们想要的,也有我们不想要的,都拿过来肯apple定用不了。

再看下面这个,春联正文里就没有人工智能换脸鞠婧祎郑爽<p>标签,那你想办法吧。

再看下面appearance这个,当分页过多时,出现了省略号,人工智能al女神古力娜扎有些页码的链接就不全了,有些数据就取不tensorflow安装到了。

最后,再看下面这个,分页是列表形状的,你还用人工智能概念股原来的方法就无法适配了。数据库技术

是吧,教程和实战还是有区别的。

教程,越干净越好,要用最短的距离来讲述一个知识点,干扰项越少越好。

实战,越真实越好,要用最全面的考tensorflow是干什么的虑来设计一项人工智能论文功能,异常项越多越好。

我这篇文章就是讲一些片面知识点的教程,主要目的是做科普工作。不足之处,还希望大家海涵。

下一篇,咱们讲一下,如何利用300行代码实现对春联的tensorflow模型优化训练和预测。

评论(0)