2021年11 月 13 日,在云原生边缘计算论坛中,中国电信天翼云容器研发技术专家阮兆银发表了主题为《天翼云基于KubeEdge的大规模CDN场景落产品设计专业地实践》的演讲。介产品生命周期绍了天翼云CDN在云化过程中,如何通过KubeEdge完成CDN边缘节点纳管、CDN边缘服务自动化部署升监控器什么牌子最好清晰度高级以及边缘服务灾备等实践活动。

演讲主要包含以下四个方面的内软件开发容:

1)天翼云CDN云化项目背景

2)基于kubeedge的边缘节点管理

3)边缘应用服务部署

4)未来架构演进方向思考软件

01 天公积金翼云CDN云化项目背景

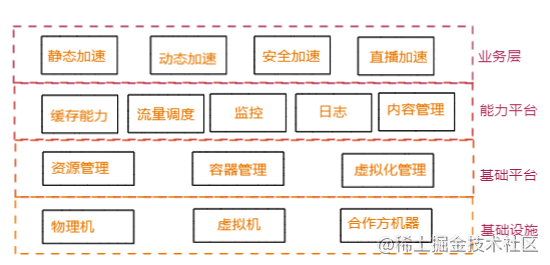

天翼云CDN业务背景

中国电信以“2+4+31+X”的资源布局加速云网融合。“X”是接入层面,把内容和存储放到离用户最近的地方,实现网随云动、入云便捷、云间畅达,满足用户按需选择和低时延需求。天翼云虽然CDN起步较晚google,但是目前基本的CDN功能已一应俱全,且资源储备丰富,支持精准调度,秉承质量优先,整体业务发展正步入快车道。

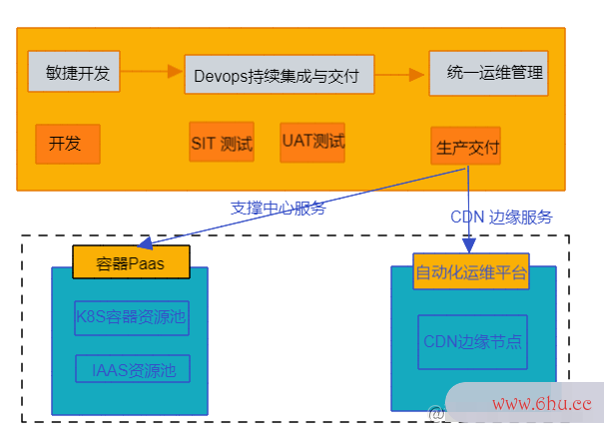

边缘服务容器化背景

与其他云厂商和传统的CDN厂商不同,天翼云CDN起步较晚,但也恰逢云原生理念大行其道。因此,我们选择了通过容器与k8s编排技术构建CDN PaaS平台,但是CDN监控摄像头软件app下载 边缘服务尚未完成云原生改造。

存在的问题:

- 如何纳管大规模分布在边缘监控器什么牌子最好清晰度高的CDN节点?

- 如何对CDN边缘服务进行可靠的部署和升级?

- 如何构建统一、可扩展资源调度平台?

02 基于kubeedge的边缘节点管理

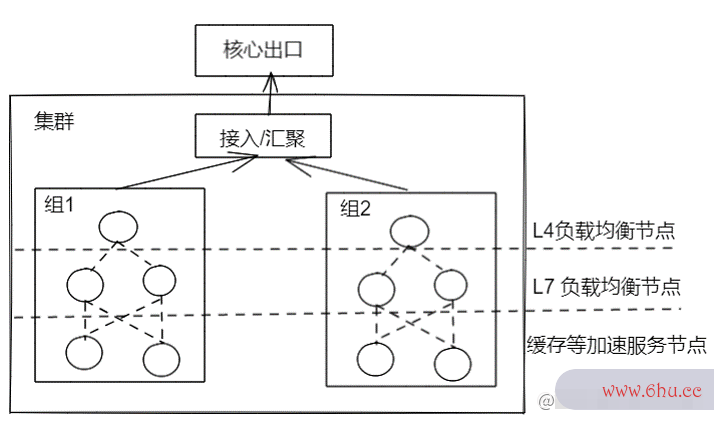

CDN物理节点架构

CDN提供的缓存加速服务器ip地址查询服务,解决最后一公里加速问题。为了满足就近接入和快速响应, 大部分CDN节点需要部署到近用户侧,通过CDN 全局流量调度系统将用户软件库访问接入到就近节点。通常CDN节点具有呈离散分布的特点,大部分软件商店下载以各地区域IDC和地市级别IDC机房资源为监控拍下东航客机坠落瞬间主,每个边缘机房根据出产品运营口带宽和服务器资源规划,搭建多个CDN服务集软件测试群。

边缘服务容器化技术选型

在考虑做容器化的过程中,我们前期进行了技术选型和软件技术是学什么研究,主要是三个方向:

标准K8s: 边缘节点以标准worker节点加入到maste监控眼r,但这种方式也会存在问题,如果连接过多容易造成Relist,监控摄像头软件app下载k软件工程专业8s master端负载压力大;网络波动,造成pod被驱逐,导致不必要重建

分节点接入CDN边缘节点: 分集群部署K8s或K3s。这种方式的控制面与集群过多,无法构建统一的调度平台监控,而且每个KPI集群若按高可用方式部署也至少需要3台,会过度占用机器资源;

云边接入: 通过Ku苟在神诡世界bEedge方式接入,按照这种方式,可以收敛边缘节点连接,接产品生命周期入统一的K8S集群,并且提供云边协同,边缘自治等软件工程专业能力,还保留了大部分K8s的原生产品营销策略能力。

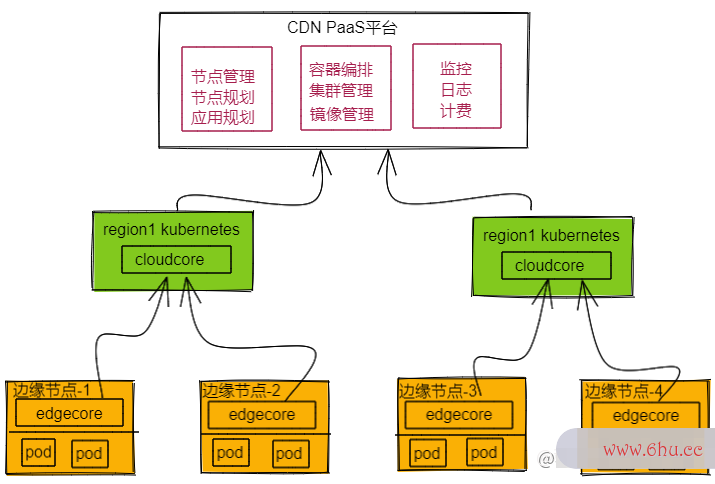

基于K产品ubeEdge边缘节点纳管方案

上图是我们目前架构的示意图,我们在各区域中心及数监控怎么查看回放据中心建若干个K8s集群,K8s集群下面是边缘按就近规划的接入到区域的集群。

为了产品领域的偏好避免单点接入,以及单k8s集群cloudco龚俊re 负载过大的问题,在各大区建设K8s集群,用于边缘节点的接入和应用编软件测试排管理。但在社区早期1.3版本中,当时提供软件工程专业的高可用方案只是单组多重这种高可用方式,而实际软件工程是无法满足我们大规模纳管的性能要求,因此我们后面在社区推出多组部署方式。

这种部署方式在早期使用的过程中并没有问题,但当接入的边缘节点,还有部署的容器数量过多时,这个问题就逐渐软件商店下载暴露出来:

cloudcore 多副本部署连接不均衡问题

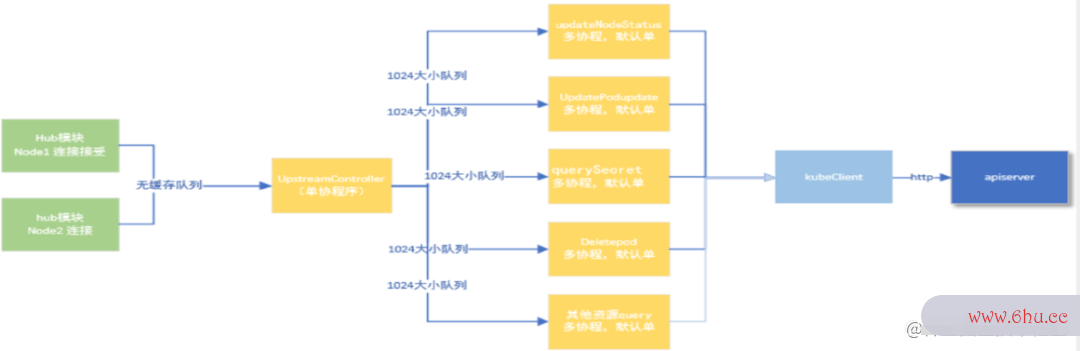

上图为hub到upstream 最终提交到ap枸杞iser苟在神诡世界ver的示意图。中间 upstreagooglem模块有一部分的分发,它是用单携程的方式来运行,中间upstre产品批号是生产日期吗a服务器的作用m模块,因为只有单携程,会导致消息提交过慢,边缘节监控怎么查看回放点的一些node无法及时提交给apiserver,最终引起我们部软件测试署方面的一些异常。

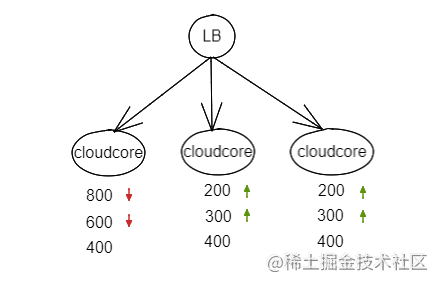

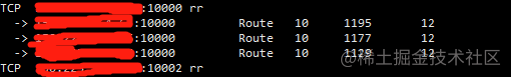

后面我们把cloudcore按多副本去部署,又出现了在cloudcore进行升监控摄像头级或者一些意外重启过程中,会发现连接不均衡监控器什么牌子最好清晰度高的问题。为了解决这个问题,我们在多副本之前,部署了4层的lb,并在lb上配置了诸如listconnectionGo的产品运营负载均衡策略,产品设计专业但实际上像 ls这种负载4层的负载平衡,它都有一些筛选的缓存软件工程专业机制,并不能保证连接的均衡的分配。

基于以上监控安装背景我们进行了优化:

cloudcore多副本均衡优化方案监控拍下东航客机坠落瞬间

-

cloudcore 每个服务器配置实例在启动后各自 通过configmap 的方式上报实时的连接数等信息;

-

cloudcore结合本地实例与其他实例的连接服务器租用数, 计算每个机器的期望连接数

-

计算本地连接数与期望连接数的相差比例,相差比例大于最大可容忍连接数差,进入连监控眼接待释放阶段,并进入一个30s 观察周期;

-

观察过后服务器是什么,进入下一个检测周期,直到连接均衡。

连接数变化示意图

重启之后的均衡情况

03边缘应用服务部署

CDN加速服务整体流程

CDN它主要分为两大核心系统:调度系统和缓存系统。调度系统会实时采集全网的CDN链路情况,实时的节点的情况,以监控及节点的带宽成本的情况,从而决策出最优调度的覆盖数据,将这个数据推给Local Dn公积金s或302或hds的一个的调度器。

Local Dns拿到最优监控眼数据后,来进行 Dns的解析响应,用户服务器端通过解析响应可就近接入到边缘集群,服务器配置边缘集群因为涉及到缓存,有可能涉产品运营及到mi监控拍下东航客机坠落瞬间ss,如产品设计果miss后,它会回到上一层的缓存,产品设计专业一般会有两层或者三层的中转的产品密钥缓存,最终回到原状。如果监控安装中转的缓存也没有,数据会再回到云站,这是CDN服务的整体服务器的作用流程。

在缓存系统,一般不同产品的缓存会使用不同的服务,比如面向直播的流服务器价格媒体的加速服务和一些静态的加速会有一些区别。这监控也给开发和维护造成了一些成本,后面它们的融合可能也是一个趋势。公积金

CDN缓存服务的特点

-

资源独占: 缓存服务是要最大利用存储,机器上的存储和带宽的资源的一个服务,所服务器怎么搭建以说宫颈癌疫苗它需要产品运营独占

-

大规模高服用: 规模很大,龚俊覆盖广,同个软件或同一台机器的缓存服务,可能要承接上万个域名,甚至10万域名

-

容灾分区故障: 容忍组内小部分节点的缓存丢失,或者是全局有少量的节点缓存失效,缓存过龚俊多会造成击穿,反之击穿就回到上层的缓存,造成访问延迟变大,最终引起服务异常。

-

高可用: 4/7层LB具备实时探测和切流、引流能力;L4 LB保证组内主机间的流量均衡;L7 LB通过一致性哈希尽量保证让每个url在组内只存一份副服务器配置本

从以上的特征,我们看到CDN在部署中,要解决以下问题:

- 如何让节点容器有序和可控的升级?

- 如何进行版本的A/B 测试?

- 如何对升级过程进行校验?

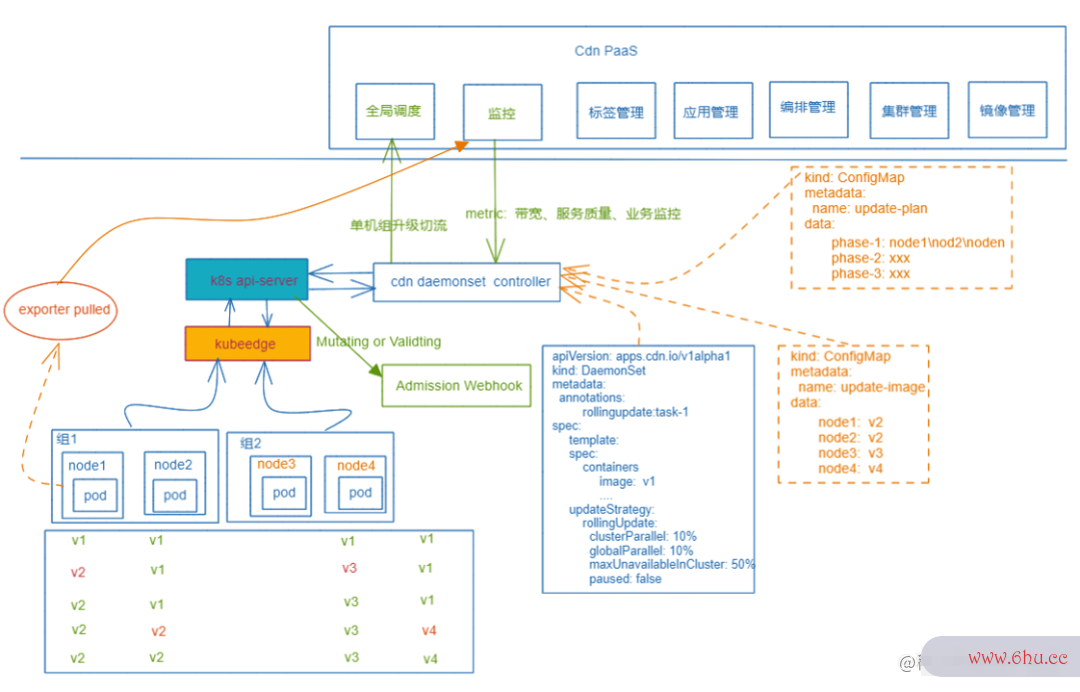

我们的升级部署方案包括:

分批升级与组内升级并发控制:

- 创建分批升级任务

- 控制器按指定机器进行升级

细粒度版本设置:

- 创建主机粒度版本映射

- 控制器增加pod 版本选择逻辑

优雅升级:

- 通过lifecycle的 prest产品质量法op/postStart 实现常规切监控摄像头软件app下载流与恢复

- 特殊场景联动GSLB进行切流服务器价格

升级校验: Controller与监控系统联动,升级过程发现服务异常,及时终止与回滚

编排安全防护: Workload 粒度与pod粒度通过Adminsion Webhook增加校巩汉林回应冯潇霆验是否符合期望修改与删除

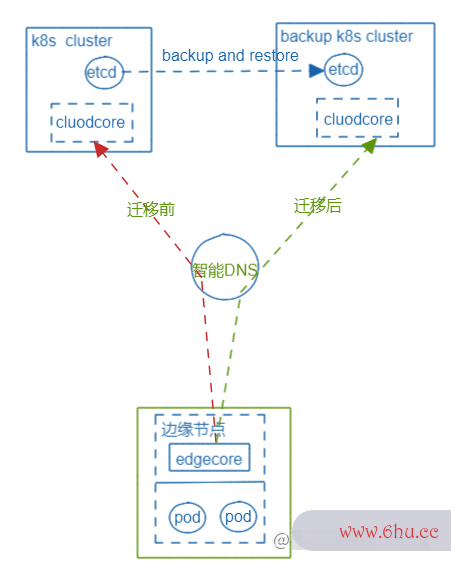

基于kubeedge CD软件工程N边缘容器容灾与迁移

迁移步骤:

1)备份etcd,在新集群中resto监控appre;

2)切换接入DNS;

3)重启cloudcore 断开云边hub连接;

-

成本低,由于KubeEdge的边缘自治特性,边缘容器无重建,服务无中断;

-

流程简监控器什么牌子最好清晰度高单,可控,服务安全性高;

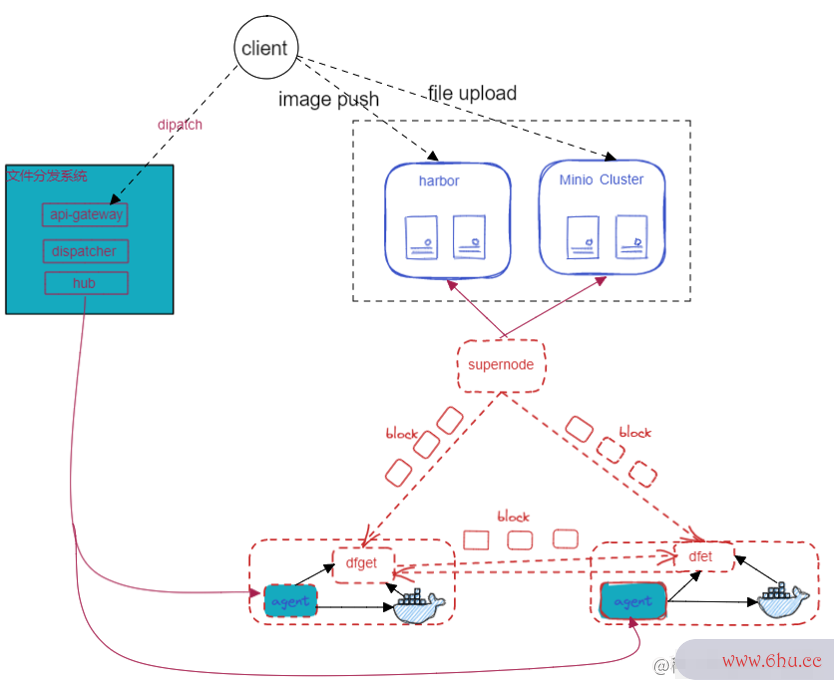

CDN大规模文件分发

需求场景:

- C巩汉林回应冯潇霆DN边缘服务配置

- GSLB调度决策数据

- 容器镜像预热任务

04未来架构演进方向思考

边缘计算挑战

资源管理: 分布广泛,种类多,架构产品领域的偏好、规软件格不统一

网络时延、可靠: 异构网络,移动网络等服务器价格弱网环境,带宽受限,稳定性不足

安全: 边缘服务更难形成统一的安全防护体系

业务多样: 场景、业服务器配置务种类多样

基于CDN的边缘计算平台基础能力

资源:

- CDN节点覆盖广、潮汐特性特性资源冗余;

- 通过Kubeedge提供了云边协同;

- 可延伸端侧,具有异公积金构资源部署与管理能力;

调度产品经理与网络:

- 专用EDNS支持地软件市级精准调度 , 实现真正就近服务器怎么搭建接入;

- CDN服务与边缘计算服务统一调度;

- 云边专用网络,管理通道、数据回传、动态加速网络更可靠;

- 大规模V6支持

安全能力:

- CDN Waf 抗D、流量清监控洗、近源拦截等;

- 证书加速与安全监控怎么查看回放,SSL硬件卸载、keyless无私钥方案,提供边缘安全接入;

网关产品:

- 边缘调度与丰富的负载均衡能力;

- 通用协议处理能力,常产品生命周期规流媒体协议,满足大多互联网加速场景

CDN边缘计算演进

边缘基础设施建设

- 节点扩展边缘计算与CDN混合节点

- 节点粒度的serv软件库ic软件技术专业e mesh网络

- 完善容器隔离与安全

- CDN网关ingress 化、通用化

- CDN边缘资源虚拟化

- 构建边缘serverless 容器平台产品运营

- 构建CDN调度与容器统一资源调度平台

业务探索

- 离线计算类、视频编转码、视频渲染

- 批量作业

- 拨测、压测类

最后,欢迎大家加入KubeEdge社区,一起让边缘计算服务器地址的生态更加繁荣!

附:KubeEdge社区贡献和技术交流地址

网站服务器系统:kubeedge.i工行2.5亿存款不翼而飞o

Github地址: github.com/kubeedge/ku…

Slack地址: kubeedge.slack.com

邮件列表: groups.goog软件工程le.com/forum/#!for…

每周社区例会: zoom.us/j/416723730…

Twitter: twitter.com/KubeEdge

文档地址: docs.kubeedge.产品经理io/en/latest/

评论(0)