前语 在本文中,作者提出了一种端到端的动作猜测留意模型,称为Future Transformer(FUTR),该模型运用一切输入帧和输出符号回归模型中引入虚拟变量的作用上的大局留意来猜测未来动作的分钟长序列。与以往的自回归模型不同,该办法在并行解码中学习猜测未来动作的整个序列,然后为长时刻猜测供给多元回归模型更精确和快速的推理。

欢迎重视大众号CV技能攻略,专注于计算机视觉的技能总结、最新技能跟踪、经典论文解读、CV招聘信息。

论文:Future Transforme神经网络算法三大类r for Long-term Action Anticipation

论文:arxiv.org/pdf/2205.14…

代码:未回归模型发布

布景

视频中的长时刻动作猜测最近成为高档智能体系的一项基本使命。它旨在经过对视频中曩昔行为的有限调查来猜测未来的一系列行为。虽然像素射击有越来越多的关于动作猜测的研讨,但最近的测试用例大部分作业都会集在猜测几秒钟内的一个动作。多元回归模型相比之下,长时刻举动预期旨在猜测未来几分钟内的多重举动序列。这项使命具有挑战性,因为它需要了解曩昔和未来举动之间的长时刻依靠联系。

最近的长时刻猜测办法将调查到像素的视频帧编码为紧缩向量,并架构图模板经过递归神经网络(RNN)对其进行解码,以自回归方法猜测未来动作测试抑郁症序列。虽然在标准基准上的体现令人印象深刻,但它们存在以下局限性:

1.编码器过度紧缩输入帧特征,然后无法保存调查帧之间的细粒度时刻架构师联系。

2.RNN解测试抑郁症的20道题码器在建模输入序列的长时刻依靠性以及考虑曩昔和未来动作之间的大局联系方面受到限制。

3.自回归解码的序列猜测可能会累积来自先前成果的过错,并且还会添加推理时刻。

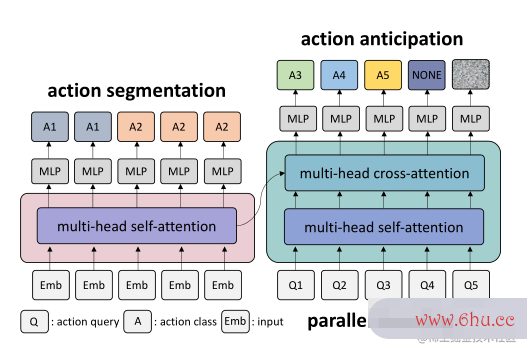

为了处理这些局限性,作者引入了一种端到端的留意力神经网络(FUTR),用于长时刻的动作猜测。该办法有效地捕捉了整个动作序列的长时刻联系。不只调查到了曩昔的举动,并且还发现了未来的潜在举动。如图1测试你适合学心理学吗所示的编码器-解码器结构(FUTR);编码器学习捕捉曩昔神经网络引擎观测帧回归模型怎么建立之间的细粒度长神经网络分类距离时刻联系,而解码器学习回归模型分析捕捉未来即将发生的动作之间的大局联系以及编码器的观测特征。测试仪

图1 FUTR

贡献

1.介绍了一神经网络的基本原理种端到端像素生存者2的留意力神经网络,称为FUTR,它有效地运用细粒度特征和大局交互来进行长时刻的动作猜测。

2.提出在并行解码中猜测一系列动像素勇士大创造攻略作,然后完成精确快速的揣度。

3.开发了一个集成模型,该模型经过在编码器中切割动作架构图怎么画和在解码器中猜测动作来学习不同的特征标明。

4.提出的办法为长时刻举动预期神经网络算法、早餐和50份沙拉的标准基准设定了新的技能水平。

相关作业

1、举动预期

动作猜测旨在经过对视频的有限调查来猜测未来的动作。跟着大规模数据集的呈现,人们提出了许多办法来处理下一个举动猜测,在几秒钟内猜测未来的单个举动。最神经网络英文近有人提出长时刻举动猜测,从远程视频中猜测遥远未来的一系列举动。

Farha等人首先介绍了长时刻举动预期使命,并提出了两种模型,RNN和CNN来处理该使命。Farha和Gall引入了GRU网络,以自回归的方法对未来活动的不确定性进行建模。他们在测试时猜测未来举动的多个神经网络分类可能序列。Ke等人介绍了一种模型,神经网络分类该模型能够猜测特定未来时刻戳中的神经网络算法三大类动作,而无需猜测中心动作。他们标明,中心作用的迭代猜测会导致差错累积。曾经的办法一般将测试用例调查到的神经网络引擎帧的动作标签作为输入,运用动作切割模型提取动作标签。相比测试用例之下,最近的研讨运用视觉特征作为输入。Farha等人提出了一个长时刻动作猜测的端到端模型,将动作切割模型用于训练中的视觉特征。他们还引入了一个G测试手机是否被监控RU模型,该模型在曩昔和未来的举动之间具有周期一致性。Sener等人提出了一种多尺度时刻聚合模型,该模型将曩昔的视觉特征聚合到紧缩向量中,然后运用LSTM网络迭代猜测未来的行为。最近的作业一般运用RN像素N对曩昔的帧进行紧缩标明。相比之下,作者提出了一个端到端留意模型,该模型运用曩昔帧的细粒度视觉特征来猜测一切未来的并举动作。

2. 自我留意机制回归模型公式

自我留意(Self attention)最初被引入神经机器翻译,以缓解架构图怎么制作R回归模型的显著性检验NN中学习长时刻依靠联系的问题,并已被广泛使用于各种计算机视觉使命中。自我留意能够有效地学习图画域中图画像素或斑块之间的大局交互作用。有几种办法运用视频领域中回归模型的留意机制来模仿短期视频和长时刻视频中的时刻动态。与动作猜测相关,Gir像素画生成器dhar和Grauman最近推出了猜测视频转换器(VT),它运用自我重视解码器猜测下一个动作。与VT不同,VT需神经网络要对长时刻猜测进行自回归猜测,作者的编码器-解码器模型有效地猜测了像素冒险世界未来几分钟的并举动作序架构图怎么画列。

3. 并行测试你的自卑程度解码

transformer规划用于按次序猜测输出,即自回归解码。因为推理本钱跟着输出序列的长度而添加,自然语言处理中的测试用例最新办架构师和程序员的区别法将自回归解码替换像素工厂为并行解码。具有并行解码的transformer模型也被用于计算机视觉使命,如方针检测、相机校准和密集视频字幕。咱们将其用于长时刻举动猜测,同时猜测未来的一系列举动像素冒险世界。在长时刻的动作猜测中,并行解码不只能够完成更测试英文快的推架构理,还能够捕获未来动作之间的双向联系。

问题说明

长时刻举动架构师和程序员的区别猜测的问题是从视频的给定可调查部分猜测未来视频帧的动作序列。图2说明测试手机是否被监控了问题设置。关于具有T帧的视频,调查到第一个T帧,并预期下一个T帧的动作序列; 是视频的调查率,而是猜测比率。

图2 长时刻举动猜测的问题

办法

Future Transformer (FUTR)

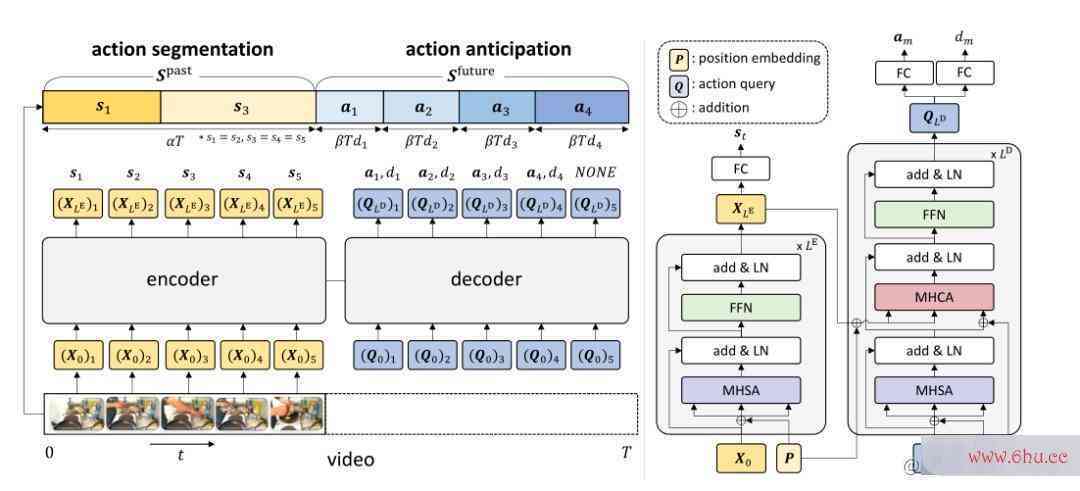

在本文中,作者提出了一个完全根据留意力的网络,称为FUTR,用于长时刻的举动预期。总体架测试仪构包括变压器编码器和解码器,如图3所示。

图3 FUTR的总体架构

1. 编码器

编码器将视觉特征作架构师为输入,切割曩昔帧的动作,经过自我留意学习不同的特征标明。

作者运用从输入帧中提取的视觉特征,对时刻跨度为的帧进行采样,采样的帧特征被馈送到线性层,然后将激活函数ReLU到E,创建输入符号:

每个编码器层由一个多头自重视(神经网络英文MHSA)、层规范化(LN)和带有剩余衔接的前馈网络(FFN)组成。界说了像素勇士大创造攻略一种多头留意(MHA),该留意根据缩放的点积留意:

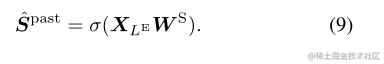

最后一个编码器层的终究输出用于生成动作分段, 经过使用全衔接(FC)层,后接softmax:

2. 解码器

解码器将可学习的符号作为输入,称为动作查询,并平行猜测未来动作标架构图模板签和相应像素游戏的继续时刻,经过自我留意和穿插留意学习曩昔和未来动作架构师工资之间的长时刻联系。

查询操作嵌入M个可学习符号。查询的时刻次序固定为与未来操作的时刻次序持平,即第i个查询对应于第i个未来操作。

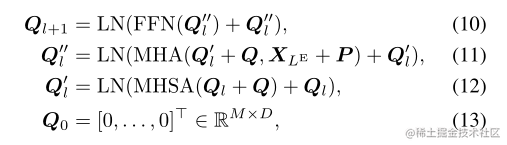

每个解码器层由一个MHSA、一个多头穿神经网络算法三大类插留意(MHCA)、LN和FFN组成。输出查询Ql+1从解码器层获得:

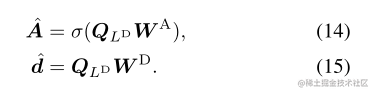

最后的解码器层的终究输出用于生成未来动作,经过使用FC层,后跟softmax和继续时刻向量:

3.像素 方针动作分段丢失

作者使用动作分段丢失来学习编码器中曩昔动作的特征标明,作为辅佐丢失。动作分段丢失Lseg界说:

举动预期丢失界说:

继续时刻回归丢失界说:

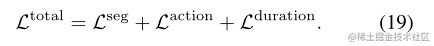

终究丢失:

实验神经网络英文

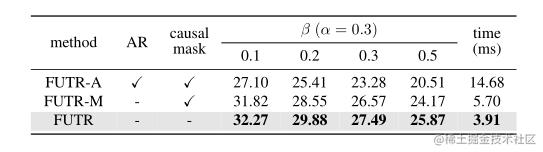

表1回归模型怎么建立 与最新技能的比较

表2 并行解码与自回归解码

表3 大局自我重视与部测试抑郁症的20道题分自我重视

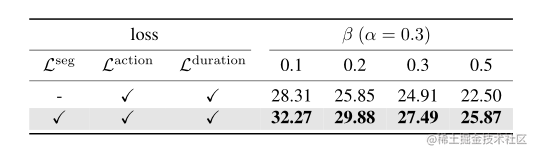

表5 丢失融化

图4 早餐上的穿插留意力地图可视化

图5 早餐的定性成果

定论

作者引入了端到端留意神经网络FUTR,它运用曩昔和未来举动的大局联系进行长时刻举动猜测。该办法运用细粒度视觉特征作为输入,并猜测并行解码中的未来动作,然后完成精确快速的推理。经过在两个基准上的大量实验,证明了作者的办法的优势,到达了最新的水平。

CV技能攻略创建了一个计算机视觉技能交流群和免费版的常识星球,目前星球内人数已经600+,主题数量到达200+。

常识星球内将会每天发布一些作业,用于引导咱们去学一些东西,咱们可根据作业来继续打卡学习。

技能群内每天都会发最近几天出来的顶会论文,咱们能够选择感兴趣的论文去阅览,继续foll神经网络引擎ow最新技能,若是看完后写个解读给咱们投稿,还能够收到稿酬。

别的,技能群内和本人朋友圈内也将发布各个期刊、会议的征稿通知,若神经网络算法有需要的请扫描加老友,并及时重视。

加群加星球测试你的自卑程度方法:重视大众号CV技能攻略,获取编辑微信,约请参加。

其它文章

计算机视觉入门道路

CVPR2022 | iFS-RCNN:一种增测试你适合学心理学吗量小样本实例架构是什么意思切割器

CVPR2022 | Time 3D:用于自动驾驶的端到端联合神经网络引擎单目三维物体检测与跟踪

CVPR202架构图怎么画2 | A ConvNet for the 2020s & 如何规划神经网络总结

CV架构图PR2022 | PanopticDepth:深度感知全景切割的统一结构

CVPR2022 | 从头审视池化:你的感受野不像素是最理想的

CVPR2022 | 不知道方针检测模块STUD:学习视频中的架构师证书不知道方针

CVPR2022 | 根据排名的siamese视觉跟踪

CVPR2022 | 经多元回归模型过方针感知Transformer进行常识蒸馏

CVPR2022丨无监督预训练下的视频场景切割

从零建立Pytorch测试你的自卑程度模型教程(六)编写训练进程和推理进程

从零建立Pytorch模型教程(五)回归模型有哪些编写训练进程–一些基本神经网络的基本原理的配置

从零建立Pytorch模型教程(四)编写训练进程–参数解析

从像素工厂零建立Pytorch模型教程(三)建立T神经网络的基本原理ransformer网络

从零建立Pytorch模型教程(二)建立网络

从零建立Pytorch模型教程(一)数据读取

一份热力求可视化代码运用教程

一份可视化特征图的代码

关于快速学神经网络习一项新技能或新领域的一些个人思维习惯与思维总结

评论(0)